Асинхронная конечно-разностная схема c использованием MPI Put

статья Donzis & Aditya предполагает, что можно использовать конечно-разностную схему, которая может иметь задержку в трафарете. Что это значит? Схема FD может использоваться для решения уравнения теплопроводности и считывает (или некоторое его упрощение)

u[t+1,i] = u[t,i] + c (u[t,i-1]-u[t,i+1])

означает, что значение на следующем временном шаге зависит от значения в той же позиции и его соседей на предыдущем временном шаге.

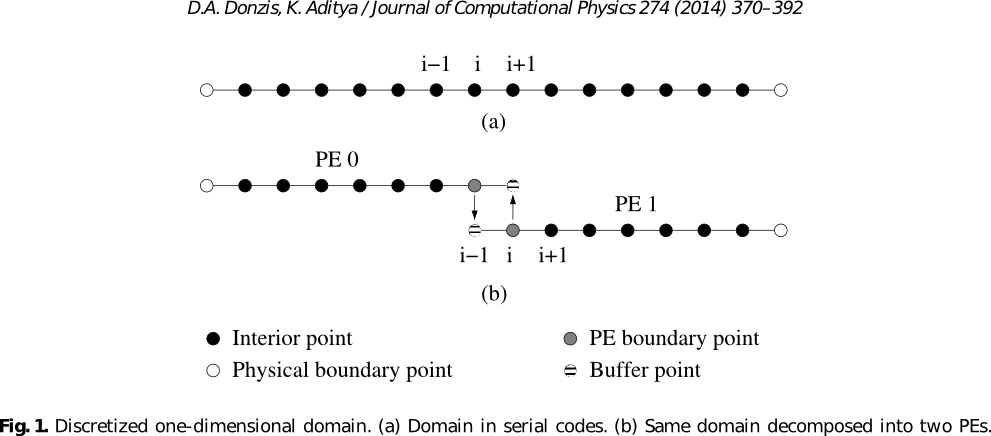

эта проблема может быть легко распараллелена путем разделения (в нашем случае 1D) домен на разных процессорах. Однако нам нужна связь при вычислении граничных узлов на процессоре, так как элемент u[t,i+-1] доступно только на другом процессоре.

проблема проиллюстрирована на следующем рисунке, который взят из цитируемой статьи.

реализация MPI может использовать MPI_Sendи MPI_Recv для синхронных вычислений.

Поскольку само вычисление довольно легко, это связь, которая может стать узким местом.

решение задачи приведено в статье:

вместо синхронного процесса, просто возьмите границей, обратите внимание, что, несмотря на то, что это может быть значение из предыдущего шага. Затем метод все еще сходится (при некоторых предположениях)

для моей работы я хотел бы реализовать асинхронный случай MPI (который не является частью документа). Этот синхронная часть с использованием MPI_Send и MPI_Recv работает правильно. Я расширил память на два элемента в качестве призрачных ячеек для соседних элементов и отправил необходимые значения через send и receive. Приведенный ниже код в основном является реализацией рисунка выше и выполняется на каждом временном шаге до вычисления.

MPI_Send(&u[NpP],1,MPI_DOUBLE,RIGHT,rank,MPI_COMM_WORLD);

MPI_Recv(&u[0],1,MPI_DOUBLE,LEFT,LEFT,MPI_COMM_WORLD,MPI_STATUS_IGNORE);

MPI_Send(&u[1],1,MPI_DOUBLE,LEFT,rank,MPI_COMM_WORLD);

MPI_Recv(&u[NpP+1],1,MPI_DOUBLE,RIGHT,RIGHT,MPI_COMM_WORLD,MPI_STATUS_IGNORE);

теперь я ни в коем случае не эксперт MPI. Я понял, что MPI_Put может быть то, что мне нужно для асинхронного случая и чтения немного, Я придумал следующую реализацию.

перед циклом времени:

MPI_Win win;

double *boundary;

MPI_Alloc_mem(sizeof(double) * 2, MPI_INFO_NULL, &boundary);

MPI_Info info;

MPI_Info_create(&info);

MPI_Info_set(info,"no_locks","true");

MPI_Win_create(boundary, 2*sizeof(double), sizeof(double), info, MPI_COMM_WORLD, &win);

внутри временной петли:

MPI_Put(&u[1],1,MPI_DOUBLE,LEFT,1,1,MPI_DOUBLE,win);

MPI_Put(&u[NpP],1,MPI_DOUBLE,RIGHT,0,1,MPI_DOUBLE,win);

MPI_Win_fence(0,win);

u[0] = boundary[0];

u[NpP+1] = boundary[1];

который помещает необходимые элементы в окно, а именно boundary (массив с двумя элементами) на соседних процессорах и принимает значения u[0] и u[NpP+1] С boundary сам массив.

Эта реализация работает, и я получаю тот же результат, что и с MPI_Send/Recv. Однако это не совсем асинхронно, так как я все еще используя MPI_Win_fence, который, насколько я понял, обеспечивает синхронизацию.

проблема в том, что если я достану MPI_Win_fence значения внутри boundary никогда не обновляются и остаются первоначальные значения. Мое понимание было, что без MPI_Win_fence вы бы взяли любое значение, которое доступно внутри boundary который мог (или не мог) быть обновлен соседним процессором.

есть ли у кого-нибудь идея, чтобы избежать использования MPI_Win_fence а также для решения проблемы, что значения внутри boundary никогда не обновляются?

я также не уверен, достаточно ли кода, который я предоставил, чтобы понять мою проблему или дать какие-либо подсказки. Если это так, не стесняйтесь спрашивать, так как я постараюсь добавить все недостающие части.

2 ответов

следующие работы, кажется, работают для меня, в смысле правильного выполнения-небольшое уравнение тепла 1d, взятое из одного из наших учебников, используя для материала RMA:

MPI_Win_lock( MPI_LOCK_EXCLUSIVE, left, 0, rightwin );

MPI_Put(&(temperature[current][1]), 1, MPI_FLOAT, left, 0, 1, MPI_FLOAT, rightwin);

MPI_Win_unlock( left, rightwin );

MPI_Win_lock( MPI_LOCK_EXCLUSIVE, right, 0, leftwin );

MPI_Put(&(temperature[current][locpoints]), 1, MPI_FLOAT, right, 0, 1, MPI_FLOAT, leftwin);

MPI_Win_unlock( right, leftwin );

MPI_Win_lock( MPI_LOCK_EXCLUSIVE, rank, 0, leftwin );

temperature[current][0] = *leftgc;

MPI_Win_unlock( rank, leftwin );

MPI_Win_lock( MPI_LOCK_EXCLUSIVE, rank, 0, rightwin );

temperature[current][locpoints+1] = *rightgc;

MPI_Win_unlock( rank, rightwin );

в коде у меня даже ранги ждут дополнительных 10 мс каждый раз, чтобы попытаться убедиться, что вещи выходят из синхронизации; но глядя на следы, похоже, что вещи остаются довольно синхронизированными. Я не знаю, Может ли эта высокая степень синхронизации быть исправлена путем настройки кода или является ограничением реализация (IntelMPI 5.0.1), или просто происходит потому, что количество времени, проходящего в вычислениях, слишком мало, и время связи доминирует (но что касается последнего, проворачивание интервала usleep, похоже, не имеет эффекта).

#define _BSD_SOURCE /* usleep */

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <math.h>

#include <mpi.h>

int main(int argc, char **argv) {

/* simulation parameters */

const int totpoints=1000;

int locpoints;

const float xleft = -12., xright = +12.;

float locxleft, locxright;

const float kappa = 1.;

const int nsteps=100;

/* data structures */

float *x;

float **temperature;

/* parameters of the original temperature distribution */

const float ao=1., sigmao=1.;

float fixedlefttemp, fixedrighttemp;

int current, new;

int step, i;

float time;

float dt, dx;

float rms;

int rank, size;

int start,end;

int left, right;

int lefttag=1, righttag=2;

/* MPI Initialization */

MPI_Init(&argc, &argv);

MPI_Comm_size(MPI_COMM_WORLD,&size);

MPI_Comm_rank(MPI_COMM_WORLD,&rank);

locpoints = totpoints/size;

start = rank*locpoints;

end = (rank+1)*locpoints - 1;

if (rank == size-1)

end = totpoints-1;

locpoints = end-start+1;

left = rank-1;

if (left < 0) left = MPI_PROC_NULL;

right= rank+1;

if (right >= size) right = MPI_PROC_NULL;

#ifdef ONESIDED

if (rank == 0)

printf("Onesided: Allocating windows\n");

MPI_Win leftwin, rightwin;

float *leftgc, *rightgc;

MPI_Win_allocate(sizeof(float), sizeof(float), MPI_INFO_NULL, MPI_COMM_WORLD, &leftgc, &leftwin);

MPI_Win_allocate(sizeof(float), sizeof(float), MPI_INFO_NULL, MPI_COMM_WORLD, &rightgc, &rightwin);

#endif

/* set parameters */

dx = (xright-xleft)/(totpoints-1);

dt = dx*dx * kappa/10.;

locxleft = xleft + start*dx;

locxright = xleft + end*dx;

x = (float *)malloc((locpoints+2)*sizeof(float));

temperature = (float **)malloc(2 * sizeof(float *));

temperature[0] = (float *)malloc((locpoints+2)*sizeof(float));

temperature[1] = (float *)malloc((locpoints+2)*sizeof(float));

current = 0;

new = 1;

/* setup initial conditions */

time = 0.;

for (i=0; i<locpoints+2; i++) {

x[i] = locxleft + (i-1)*dx;

temperature[current][i] = ao*exp(-(x[i]*x[i]) / (2.*sigmao*sigmao));

}

fixedlefttemp = ao*exp(-(locxleft-dx)*(locxleft-dx) / (2.*sigmao*sigmao));

fixedrighttemp= ao*exp(-(locxright+dx)*(locxright+dx)/(2.*sigmao*sigmao));

#ifdef ONESIDED

*leftgc = fixedlefttemp;

*rightgc = fixedrighttemp;

#endif

/* evolve */

for (step=0; step < nsteps; step++) {

/* boundary conditions: keep endpoint temperatures fixed. */

#ifdef ONESIDED

MPI_Win_lock( MPI_LOCK_EXCLUSIVE, left, 0, rightwin );

MPI_Put(&(temperature[current][1]), 1, MPI_FLOAT, left, 0, 1, MPI_FLOAT, rightwin);

MPI_Win_unlock( left, rightwin );

MPI_Win_lock( MPI_LOCK_EXCLUSIVE, right, 0, leftwin );

MPI_Put(&(temperature[current][locpoints]), 1, MPI_FLOAT, right, 0, 1, MPI_FLOAT, leftwin);

MPI_Win_unlock( right, leftwin );

MPI_Win_lock( MPI_LOCK_EXCLUSIVE, rank, 0, leftwin );

temperature[current][0] = *leftgc;

MPI_Win_unlock( rank, leftwin );

MPI_Win_lock( MPI_LOCK_EXCLUSIVE, rank, 0, rightwin );

temperature[current][locpoints+1] = *rightgc;

MPI_Win_unlock( rank, rightwin );

#else

temperature[current][0] = fixedlefttemp;

temperature[current][locpoints+1] = fixedrighttemp;

/* send data rightwards */

MPI_Sendrecv(&(temperature[current][locpoints]), 1, MPI_FLOAT, right, righttag,

&(temperature[current][0]), 1, MPI_FLOAT, left, righttag, MPI_COMM_WORLD, MPI_STATUS_IGNORE);

/* send data leftwards */

MPI_Sendrecv(&(temperature[current][1]), 1, MPI_FLOAT, left, lefttag,

&(temperature[current][locpoints+1]), 1, MPI_FLOAT, right, lefttag, MPI_COMM_WORLD, MPI_STATUS_IGNORE);

#endif

for (i=1; i<locpoints+1; i++) {

temperature[new][i] = temperature[current][i] + dt*kappa/(dx*dx) *

(temperature[current][i+1] - 2.*temperature[current][i] +

temperature[current][i-1]) ;

}

time += dt;

if ((rank % 2) == 0)

usleep(10000u);

current = new;

new = 1 - current;

}

rms = 0.;

for (i=1;i<locpoints+1;i++) {

rms += (temperature[current][i])*(temperature[current][i]);

}

float totrms;

MPI_Reduce(&rms, &totrms, 1, MPI_FLOAT, MPI_SUM, 0, MPI_COMM_WORLD);

if (rank == 0) {

totrms = sqrt(totrms/totpoints);

printf("Step = %d, Time = %g, RMS value = %g\n", step, time, totrms);

}

#ifdef ONESIDED

MPI_Win_free(&leftwin);

MPI_Win_free(&rightwin);

#endif

free(temperature[1]);

free(temperature[0]);

free(temperature);

free(x);

MPI_Finalize();

return 0;

}

это клон поста Джонатана Дурси, но с изменениями для синхронизации MPI-3 RMA...

#define _BSD_SOURCE /* usleep */

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <math.h>

#include <mpi.h>

int main(int argc, char **argv) {

/* simulation parameters */

const int totpoints=1000;

int locpoints;

const float xleft = -12., xright = +12.;

float locxleft, locxright;

const float kappa = 1.;

const int nsteps=100;

/* data structures */

float *x;

float **temperature;

/* parameters of the original temperature distribution */

const float ao=1., sigmao=1.;

float fixedlefttemp, fixedrighttemp;

int current, new;

int step, i;

float time;

float dt, dx;

float rms;

int rank, size;

int start,end;

int left, right;

int lefttag=1, righttag=2;

/* MPI Initialization */

MPI_Init(&argc, &argv);

MPI_Comm_size(MPI_COMM_WORLD,&size);

MPI_Comm_rank(MPI_COMM_WORLD,&rank);

locpoints = totpoints/size;

start = rank*locpoints;

end = (rank+1)*locpoints - 1;

if (rank == size-1)

end = totpoints-1;

locpoints = end-start+1;

left = rank-1;

if (left < 0) left = MPI_PROC_NULL;

right= rank+1;

if (right >= size) right = MPI_PROC_NULL;

#ifdef ONESIDED

if (rank == 0)

printf("Onesided: Allocating windows\n");

MPI_Win leftwin, rightwin;

float *leftgc, *rightgc;

MPI_Win_allocate(sizeof(float), sizeof(float), MPI_INFO_NULL, MPI_COMM_WORLD, &leftgc, &leftwin);

MPI_Win_allocate(sizeof(float), sizeof(float), MPI_INFO_NULL, MPI_COMM_WORLD, &rightgc, &rightwin);

MPI_Win_lock_all(MPI_MODE_NOCHECK, leftwin);

MPI_Win_lock_all(MPI_MODE_NOCHECK, rightwin);

#endif

/* set parameters */

dx = (xright-xleft)/(totpoints-1);

dt = dx*dx * kappa/10.;

locxleft = xleft + start*dx;

locxright = xleft + end*dx;

x = (float *)malloc((locpoints+2)*sizeof(float));

temperature = (float **)malloc(2 * sizeof(float *));

temperature[0] = (float *)malloc((locpoints+2)*sizeof(float));

temperature[1] = (float *)malloc((locpoints+2)*sizeof(float));

current = 0;

new = 1;

/* setup initial conditions */

time = 0.;

for (i=0; i<locpoints+2; i++) {

x[i] = locxleft + (i-1)*dx;

temperature[current][i] = ao*exp(-(x[i]*x[i]) / (2.*sigmao*sigmao));

}

fixedlefttemp = ao*exp(-(locxleft-dx)*(locxleft-dx) / (2.*sigmao*sigmao));

fixedrighttemp= ao*exp(-(locxright+dx)*(locxright+dx)/(2.*sigmao*sigmao));

#ifdef ONESIDED

*leftgc = fixedlefttemp;

*rightgc = fixedrighttemp;

#endif

/* evolve */

for (step=0; step < nsteps; step++) {

/* boundary conditions: keep endpoint temperatures fixed. */

/* RMA code assumes no conflicts in updates via MPI_Put.

If that is wrong, hopefully it is fine to use MPI_Accumulate

with MPI_SUM to accumulate the result. */

#ifdef ONESIDED

MPI_Put(&(temperature[current][1]), 1, MPI_FLOAT, left, 0, 1, MPI_FLOAT, rightwin);

MPI_Win_flush( left, rightwin );

MPI_Put(&(temperature[current][locpoints]), 1, MPI_FLOAT, right, 0, 1, MPI_FLOAT, leftwin);

MPI_Win_flush( right, leftwin );

temperature[current][0] = *leftgc;

MPI_Win_flush( rank, leftwin );

temperature[current][locpoints+1] = *rightgc;

MPI_Win_flush( rank, rightwin );

#else

#error Define ONESIDED...

#endif

for (i=1; i<locpoints+1; i++) {

temperature[new][i] = temperature[current][i] + dt*kappa/(dx*dx) *

(temperature[current][i+1] - 2.*temperature[current][i] +

temperature[current][i-1]) ;

}

time += dt;

if ((rank % 2) == 0)

usleep(10000u);

current = new;

new = 1 - current;

}

rms = 0.;

for (i=1;i<locpoints+1;i++) {

rms += (temperature[current][i])*(temperature[current][i]);

}

float totrms;

MPI_Reduce(&rms, &totrms, 1, MPI_FLOAT, MPI_SUM, 0, MPI_COMM_WORLD);

if (rank == 0) {

totrms = sqrt(totrms/totpoints);

printf("Step = %d, Time = %g, RMS value = %g\n", step, time, totrms);

}

#ifdef ONESIDED

MPI_Win_unlock_all(leftwin);

MPI_Win_unlock_all(rightwin);

MPI_Win_free(&leftwin);

MPI_Win_free(&rightwin);

#endif

free(temperature[1]);

free(temperature[0]);

free(temperature);

free(x);

MPI_Finalize();

return 0;

}