Как проверить версию Spark

Как называется, Как узнать, какая версия spark была установлена в CentOS?

текущая система установила cdh5.1.0.

9 ответов

Если вы используете Spark-Shell, он появляется в баннере в начале.

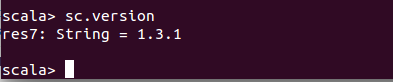

программно, SparkContext.version можно использовать.

В Spark 2.программа X/раковины,

использовать

spark.version

здесь spark переменная SparkSession объект

использование журналов консоли при запуске spark-shell

[root@bdhost001 ~]$ spark-shell

Setting default log level to "WARN".

To adjust logging level use sc.setLogLevel(newLevel).

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 2.2.0

/_/

без ввода кода / оболочки

spark-shell --version

[root@bdhost001 ~]$ spark-shell --version

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 2.2.0

/_/

Type --help for more information.

spark-submit --version

[root@bdhost001 ~]$ spark-submit --version

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 2.2.0

/_/

Type --help for more information.

какая бы команда оболочки вы ни использовали spark-shell или pyspark, она приземлится на логотип Spark с именем версии рядом с ним.

$ pyspark

$ Python 2.6.6 (r266:84292, 22 мая 2015, 08:34:51)

[GCC 4.4.7 20120313 (Red Hat 4.4.7-15)] на linux2

............

...........

Добро пожаловать в

версия 1.3.0

Если вы используете pyspark, используемая версия spark можно увидеть рядом с жирным логотипом Spark, как показано ниже:

manoj@hadoop-host:~$ pyspark

Python 2.7.6 (default, Jun 22 2015, 17:58:13)

[GCC 4.8.2] on linux2

Type "help", "copyright", "credits" or "license" for more information.

Setting default log level to "WARN".

To adjust logging level use sc.setLogLevel(newLevel).

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/__ / .__/\_,_/_/ /_/\_\ version 1.6.0

/_/

Using Python version 2.7.6 (default, Jun 22 2015 17:58:13)

SparkContext available as sc, HiveContext available as sqlContext.

>>>

Если вы хотите получить версию spark явно, вы можете использовать метод версии SparkContext, как показано ниже:

>>>

>>> sc.version

u'1.6.0'

>>>

Если вы Zeppelin notebook вы можете работать:

sc.version

чтобы узнать версию scala, вы также можете запустить:

util.Properties.versionString