Как вычислить сходство jaccard из фрейма данных pandas

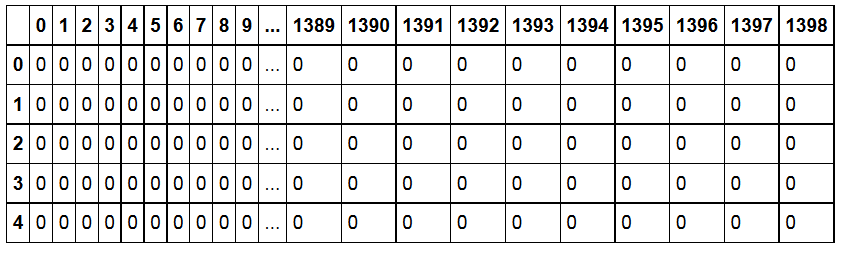

у меня есть фрейм данных следующим образом: форма фрейма (1510, 1399). Столбцы представляют продукты, строки представляют значения (0 или 1), назначенные Пользователем для данного продукта. Как я могу вычислить jaccard_similarity_score?

Я создал заполнитель dataframe список продукта против продукта

data_ibs = pd.DataFrame(index=data_g.columns,columns=data_g.columns)

Я не уверен, как итерации, хотя data_ibs для вычисления сходства.

for i in range(0,len(data_ibs.columns)) :

# Loop through the columns for each column

for j in range(0,len(data_ibs.columns)) :

.........

1 ответов

короткий и векторизованный (быстрый) ответ:

используйте "Хэмминг" из попарных расстояний scikit learn:

from sklearn.metrics.pairwise import pairwise_distances

jac_sim = 1 - pairwise_distances(df.T, metric = "hamming")

# optionally convert it to a DataFrame

jac_sim = pd.DataFrame(jac_sim, index=df.columns, columns=df.columns)

объяснение:

предположим, что это ваш набор данных:

import pandas as pd

import numpy as np

np.random.seed(0)

df = pd.DataFrame(np.random.binomial(1, 0.5, size=(100, 5)), columns=list('ABCDE'))

print(df.head())

A B C D E

0 1 1 1 1 0

1 1 0 1 1 0

2 1 1 1 1 0

3 0 0 1 1 1

4 1 1 0 1 0

использовать sklearn по jaccard_similarity_score, сходство между столбцами A и B-это:

from sklearn.metrics import jaccard_similarity_score

print(jaccard_similarity_score(df['A'], df['B']))

0.43

это количество строк, которые имеют одинаковое значение по общему количеству строк, 100.

насколько я знаю, нет попарно версия jaccard_similarity_score, но есть попарные версии расстояний.

однако, SciPy определяет расстояние Жаккара следующим образом:

учитывая два вектора, u и v, расстояние Джаккарда-это доля тех элементов u[i] и v[i], которые не согласны, где хотя бы один из них ненулевой.

таким образом, он исключает строки, где оба столбца имеют 0 значений. jaccard_similarity_score не делает. Расстояние Hamming, на с другой стороны, встроен в определение подобия:

доля этих векторных элементов между двумя n-векторами u и v которые не согласны.

поэтому, если вы хотите рассчитать jaccard_similarity_score, вы можете использовать 1-hamming:

from sklearn.metrics.pairwise import pairwise_distances

print(1 - pairwise_distances(df.T, metric = "hamming"))

array([[ 1. , 0.43, 0.61, 0.55, 0.46],

[ 0.43, 1. , 0.52, 0.56, 0.49],

[ 0.61, 0.52, 1. , 0.48, 0.53],

[ 0.55, 0.56, 0.48, 1. , 0.49],

[ 0.46, 0.49, 0.53, 0.49, 1. ]])

в формате фрейма данных:

jac_sim = 1 - pairwise_distances(df.T, metric = "hamming")

jac_sim = pd.DataFrame(jac_sim, index=df.columns, columns=df.columns)

# jac_sim = np.triu(jac_sim) to set the lower diagonal to zero

# jac_sim = np.tril(jac_sim) to set the upper diagonal to zero

A B C D E

A 1.00 0.43 0.61 0.55 0.46

B 0.43 1.00 0.52 0.56 0.49

C 0.61 0.52 1.00 0.48 0.53

D 0.55 0.56 0.48 1.00 0.49

E 0.46 0.49 0.53 0.49 1.00

вы можете сделать то же самое, повторяя комбинации столбцов, но это будет намного медленнее.

import itertools

sim_df = pd.DataFrame(np.ones((5, 5)), index=df.columns, columns=df.columns)

for col_pair in itertools.combinations(df.columns, 2):

sim_df.loc[col_pair] = sim_df.loc[tuple(reversed(col_pair))] = jaccard_similarity_score(df[col_pair[0]], df[col_pair[1]])

print(sim_df)

A B C D E

A 1.00 0.43 0.61 0.55 0.46

B 0.43 1.00 0.52 0.56 0.49

C 0.61 0.52 1.00 0.48 0.53

D 0.55 0.56 0.48 1.00 0.49

E 0.46 0.49 0.53 0.49 1.00