Как запустить пример программы spark в Intellij IDEA

сначала в командной строке из корня загруженного проекта spark я запустил

mvn package

это было успешно.

затем проект intellij был создан путем импорта spark pom.XML.

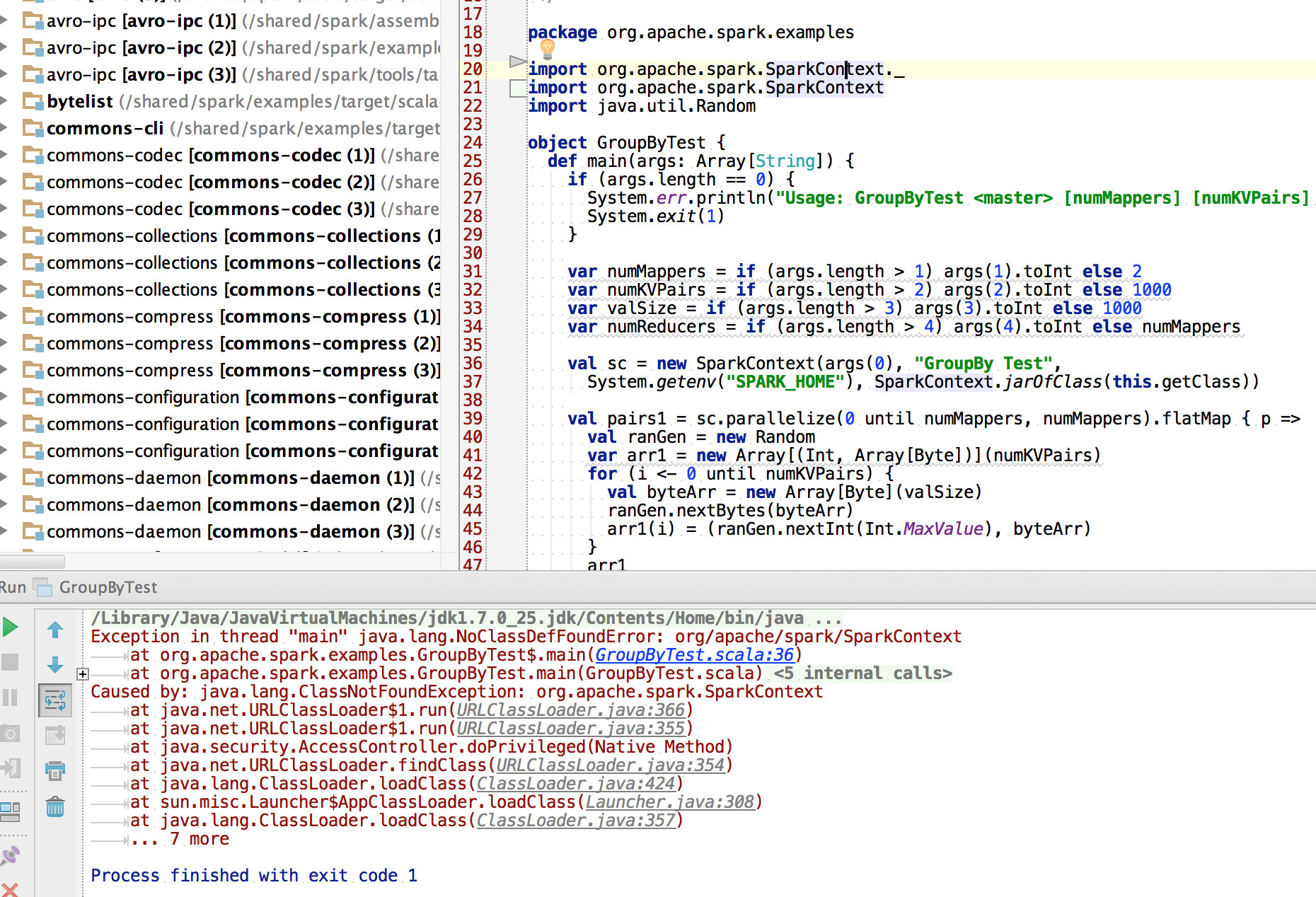

в IDE класс example выглядит нормально: все библиотеки найдены. Это можно посмотреть на скриншоте.

однако при попытке запустить main () возникает исключение ClassNotFoundException в SparkContext.

почему Intellij не просто загрузить и запустить эту программу на основе maven scala? И что можно сделать в качестве обходного пути?

Как видно ниже, SparkContext отлично выглядит в IDE: но тогда не найден при попытке запуска:

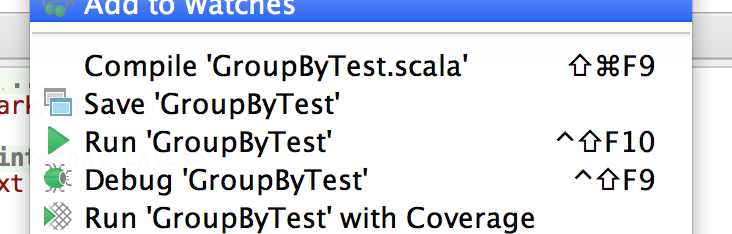

тест был запущен, щелкнув правой кнопкой мыши внутри main ():

.. и выбрав запустить GroupByTest

дает

Exception in thread "main" java.lang.NoClassDefFoundError: org/apache/spark/SparkContext

at org.apache.spark.examples.GroupByTest$.main(GroupByTest.scala:36)

at org.apache.spark.examples.GroupByTest.main(GroupByTest.scala)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:57)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

at java.lang.reflect.Method.invoke(Method.java:606)

at com.intellij.rt.execution.application.AppMain.main(AppMain.java:120)

Caused by: java.lang.ClassNotFoundException: org.apache.spark.SparkContext

at java.net.URLClassLoader.run(URLClassLoader.java:366)

at java.net.URLClassLoader.run(URLClassLoader.java:355)

at java.security.AccessController.doPrivileged(Native Method)

at java.net.URLClassLoader.findClass(URLClassLoader.java:354)

at java.lang.ClassLoader.loadClass(ClassLoader.java:424)

at sun.misc.Launcher$AppClassLoader.loadClass(Launcher.java:308)

at java.lang.ClassLoader.loadClass(ClassLoader.java:357)

... 7 more

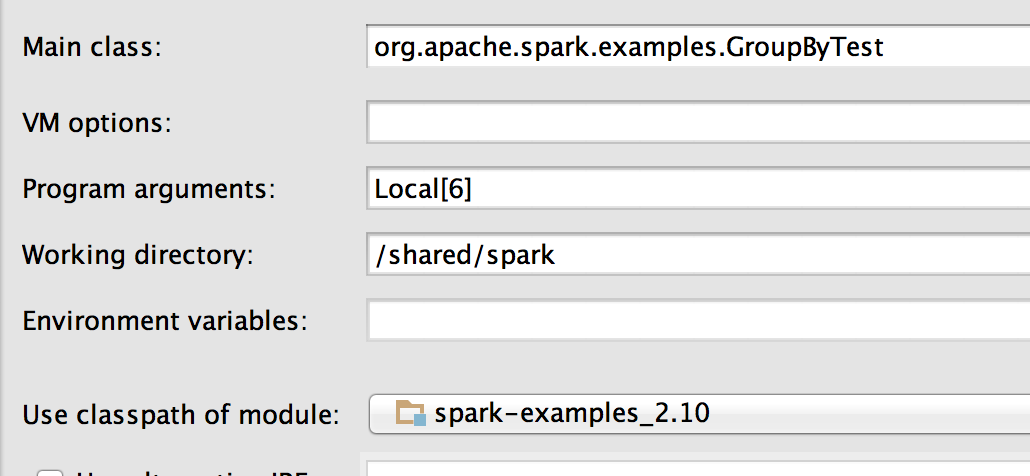

вот выполнить конфигурация:

3 ответов

Spark lib не является вашим class_path.

выполнить sbt/sbt assembly,

и после include " / assembly/target/scala-$SCALA_VERSION / spark-assembly*hadoop*-deps.jar " к вашему проекту.

Это может помочь IntelliJ-Runtime-error-tt11383. Изменение зависимостей модулей от обеспечить до compile. Это работает для меня.

вам нужно добавить зависимость spark. Если вы используете maven, просто добавьте эти строки в свой pom.XML-код:

<dependencies>

...

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_${scala.binary.version}</artifactId>

<version>${spark.version}</version>

<scope>provided</scope>

</dependency>

...

</dependencies>

таким образом, у вас будет зависимость для компиляции и тестирования, но не в артефакте "jar-with-dependencies".

но если вы хотите выполнить все приложение в автономном кластере, работающем в intellij, вы можете добавить профиль maven, чтобы добавить зависимость с областью компиляции. Вот так:

<properties>

<scala.binary.version>2.11</scala.binary.version>

<spark.version>1.2.1</spark.version>

<spark.scope>provided</spark.scope>

</properties>

<profiles>

<profile>

<id>local</id>

<properties>

<spark.scope>compile</spark.scope>

</properties>

<dependencies>

<!--<dependency>-->

<!--<groupId>org.apache.hadoop</groupId>-->

<!--<artifactId>hadoop-common</artifactId>-->

<!--<version>2.6.0</version>-->

<!--</dependency>-->

<!--<dependency>-->

<!--<groupId>com.hadoop.gplcompression</groupId>-->

<!--<artifactId>hadoop-gpl-compression</artifactId>-->

<!--<version>0.1.0</version>-->

<!--</dependency>-->

<dependency>

<groupId>com.hadoop.gplcompression</groupId>

<artifactId>hadoop-lzo</artifactId>

<version>0.4.19</version>

</dependency>

</dependencies>

<activation>

<activeByDefault>false</activeByDefault>

<property>

<name>env</name>

<value>local</value>

</property>

</activation>

</profile>

</profiles>

<dependencies>

<!-- SPARK DEPENDENCIES -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_${scala.binary.version}</artifactId>

<version>${spark.version}</version>

<scope>${spark.scope}</scope>

</dependency>

</dependencies>

Я тоже добавил опция моего приложения для запуска локального кластера, если передается --local:

private def sparkContext(appName: String, isLocal:Boolean): SparkContext = {

val sparkConf = new SparkConf().setAppName(appName)

if (isLocal) {

sparkConf.setMaster("local")

}

new SparkContext(sparkConf)

}

наконец, вы должны включить" локальный " профиль в Intellij, чтобы получить правильные зависимости. Просто перейдите на вкладку "Maven проекты" и включите профиль.