Освещение Oren-Nayar в OpenGL (как рассчитать направление просмотра в шейдере фрагментов)

Я пытаюсь реализовать освещение Oren-Nayar в шейдере фрагментов, как показано здесь.

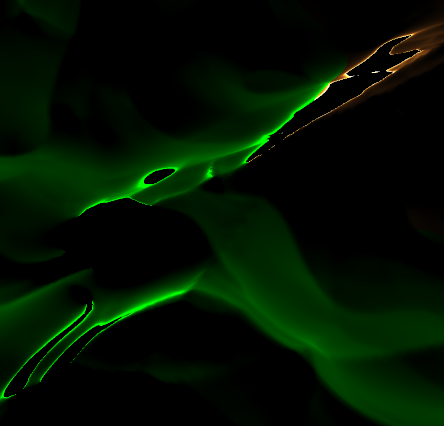

тем не менее, я получаю некоторые странные эффекты освещения на местности, как показано ниже.

в настоящее время я отправляю шейдеру форму "направление взгляда" в качестве "переднего" вектора камеры. Я не уверен, что это правильно, так как перемещение камеры вокруг изменяет артефакты.

умножение "переднего" вектора на матрицу MVP дает лучший результат, но артефакты все равно очень заметны при просмотре местности с некоторых ракурсов. Это особенно заметно в темных областях и по краям экрана.

что может быть причиной такого эффекта?

пример артефакта

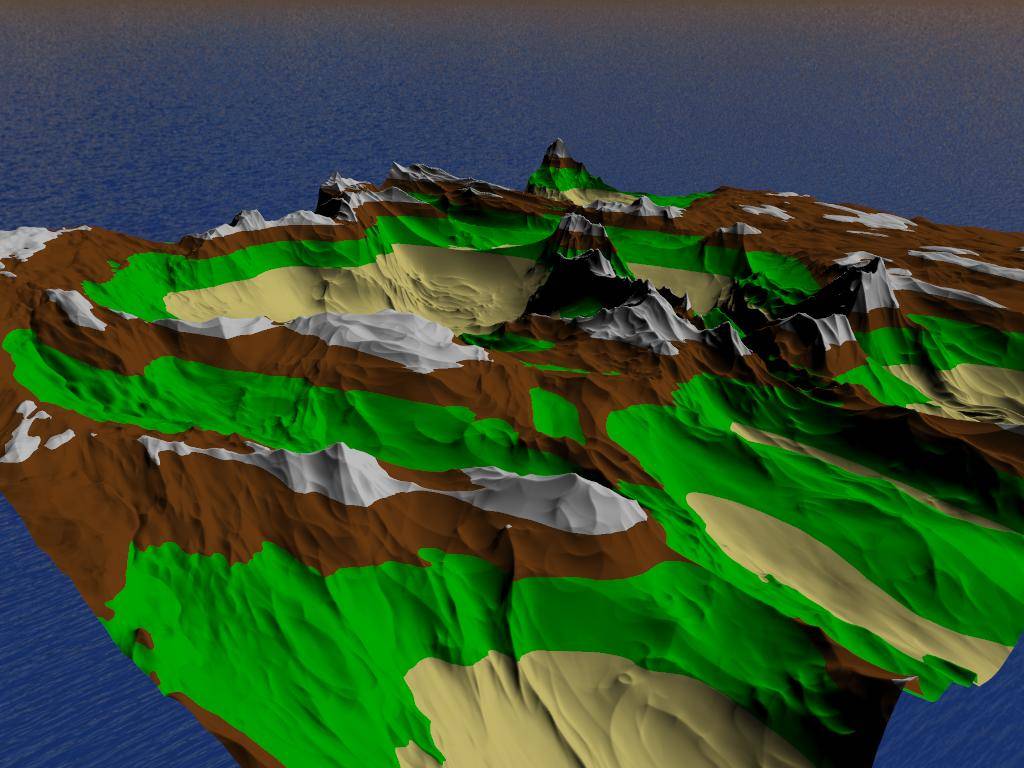

как должна выглядеть сцена

вершина Шейдер

#version 450

layout(location = 0) in vec3 position;

layout(location = 1) in vec3 normal;

out VS_OUT {

vec3 normal;

} vert_out;

void main() {

vert_out.normal = normal;

gl_Position = vec4(position, 1.0);

}

Тесселяции Управления Шейдер

#version 450

layout(vertices = 3) out;

in VS_OUT {

vec3 normal;

} tesc_in[];

out TESC_OUT {

vec3 normal;

} tesc_out[];

void main() {

if(gl_InvocationID == 0) {

gl_TessLevelInner[0] = 1.0;

gl_TessLevelInner[1] = 1.0;

gl_TessLevelOuter[0] = 1.0;

gl_TessLevelOuter[1] = 1.0;

gl_TessLevelOuter[2] = 1.0;

gl_TessLevelOuter[3] = 1.0;

}

tesc_out[gl_InvocationID].normal = tesc_in[gl_InvocationID].normal;

gl_out[gl_InvocationID].gl_Position = gl_in[gl_InvocationID].gl_Position;

}

Шейдер Оценки Тесселации

#version 450

layout(triangles, equal_spacing) in;

in TESC_OUT {

vec3 normal;

} tesc_in[];

out TESE_OUT {

vec3 normal;

float height;

vec4 shadow_position;

} tesc_out;

uniform mat4 model_view;

uniform mat4 model_view_perspective;

uniform mat3 normal_matrix;

uniform mat4 depth_matrix;

vec3 lerp(vec3 v0, vec3 v1, vec3 v2) {

return (

(vec3(gl_TessCoord.x) * v0) +

(vec3(gl_TessCoord.y) * v1) +

(vec3(gl_TessCoord.z) * v2)

);

}

vec4 lerp(vec4 v0, vec4 v1, vec4 v2) {

return (

(vec4(gl_TessCoord.x) * v0) +

(vec4(gl_TessCoord.y) * v1) +

(vec4(gl_TessCoord.z) * v2)

);

}

void main() {

gl_Position = lerp(

gl_in[0].gl_Position,

gl_in[1].gl_Position,

gl_in[2].gl_Position

);

tesc_out.normal = normal_matrix * lerp(

tesc_in[0].normal,

tesc_in[1].normal,

tesc_in[2].normal

);

tesc_out.height = gl_Position.y;

tesc_out.shadow_position = depth_matrix * gl_Position;

gl_Position = model_view_perspective * gl_Position;

}

Фрагмент Шейдеров

#version 450

in TESE_OUT {

vec3 normal;

float height;

vec4 shadow_position;

} frag_in;

out vec4 colour;

uniform vec3 view_direction;

uniform vec3 light_position;

#define PI 3.141592653589793

void main() {

const vec3 ambient = vec3(0.1, 0.1, 0.1);

const float roughness = 0.8;

const vec4 water = vec4(0.0, 0.0, 0.8, 1.0);

const vec4 sand = vec4(0.93, 0.87, 0.51, 1.0);

const vec4 grass = vec4(0.0, 0.8, 0.0, 1.0);

const vec4 ground = vec4(0.49, 0.27, 0.08, 1.0);

const vec4 snow = vec4(0.9, 0.9, 0.9, 1.0);

if(frag_in.height == 0.0) {

colour = water;

} else if(frag_in.height < 0.2) {

colour = sand;

} else if(frag_in.height < 0.575) {

colour = grass;

} else if(frag_in.height < 0.8) {

colour = ground;

} else {

colour = snow;

}

vec3 normal = normalize(frag_in.normal);

vec3 view_dir = normalize(view_direction);

vec3 light_dir = normalize(light_position);

float NdotL = dot(normal, light_dir);

float NdotV = dot(normal, view_dir);

float angleVN = acos(NdotV);

float angleLN = acos(NdotL);

float alpha = max(angleVN, angleLN);

float beta = min(angleVN, angleLN);

float gamma = dot(view_dir - normal * dot(view_dir, normal), light_dir - normal * dot(light_dir, normal));

float roughnessSquared = roughness * roughness;

float roughnessSquared9 = (roughnessSquared / (roughnessSquared + 0.09));

// calculate C1, C2 and C3

float C1 = 1.0 - 0.5 * (roughnessSquared / (roughnessSquared + 0.33));

float C2 = 0.45 * roughnessSquared9;

if(gamma >= 0.0) {

C2 *= sin(alpha);

} else {

C2 *= (sin(alpha) - pow((2.0 * beta) / PI, 3.0));

}

float powValue = (4.0 * alpha * beta) / (PI * PI);

float C3 = 0.125 * roughnessSquared9 * powValue * powValue;

// now calculate both main parts of the formula

float A = gamma * C2 * tan(beta);

float B = (1.0 - abs(gamma)) * C3 * tan((alpha + beta) / 2.0);

// put it all together

float L1 = max(0.0, NdotL) * (C1 + A + B);

// also calculate interreflection

float twoBetaPi = 2.0 * beta / PI;

float L2 = 0.17 * max(0.0, NdotL) * (roughnessSquared / (roughnessSquared + 0.13)) * (1.0 - gamma * twoBetaPi * twoBetaPi);

colour = vec4(colour.xyz * (L1 + L2), 1.0);

}

1 ответов

сначала я подключил ваш шейдер фрагмента к моему визуализатору с моими векторами вида/нормального/света, и он отлично работает. Поэтому проблема должна быть в том, как вы вычисляете эти векторы.

Далее, вы говорите, что вы устанавливаете view_dir к переднему вектору вашей камеры. Я предполагаю, что вы имели в виду "передний вектор камеры в мировом пространстве", что было бы неверно. Поскольку вы вычисляете точечные продукты с векторами в пространстве камеры,view_dir должен быть в пространстве камеры тоже. То есть vec3(0,0,1) было бы простым способом проверить это. Если это сработает ... мы нашли твою проблему.

(0,0,1) для направления взгляда строго не правильно когда вы делаете проекцию перспективы, потому что направление от части к камере после этого зависит от положения части на экране. Правильная формула тогда была бы view_dir = normalize(-pos) здесь pos - положение фрагмента в пространстве камеры (то есть с матрицей вида модели, применяемой без проекции). Дальше, это количество теперь зависит только от местоположения фрагмента на экране, поэтому его можно рассчитать как:

view_dir = normalize(vec3(-(gl_FragCoord.xy - frame_size/2) / (frame_width/2), flen))

flen - это фокусное расстояние вашей камеры, которую можно рассчитать как flen = cot(fovx/2).