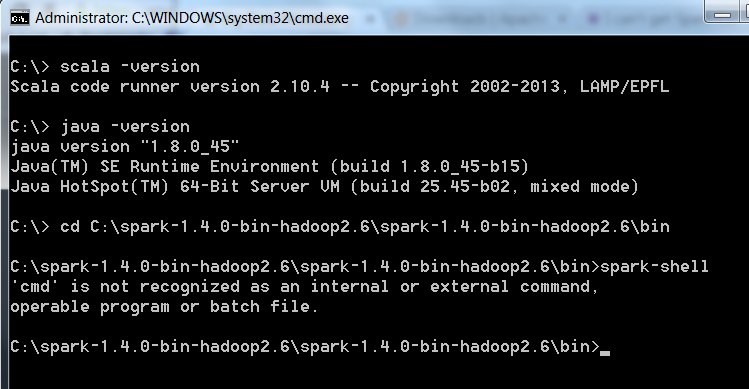

Spark: попытка запустить spark-shell, но получить "cmd" не распознается как внутренний или

Я пытаюсь установить Spark на рабочий стол Windows. Все должно работать нормально, но я получаю сообщение об ошибке "cmd" не распознается как внутренняя или внешняя команда... "

Я установил Scala, Java JDK и unzipped Spark tgz в C:, но по какой-то причине не могу запустить Spark в cmd. Есть идеи?

8 ответов

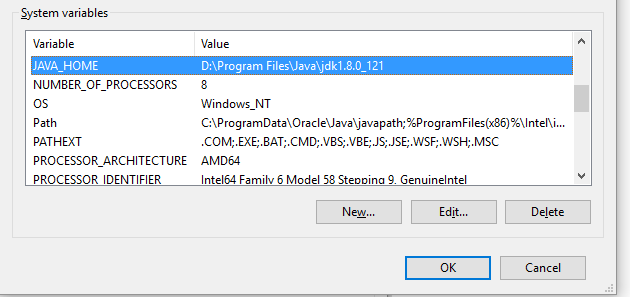

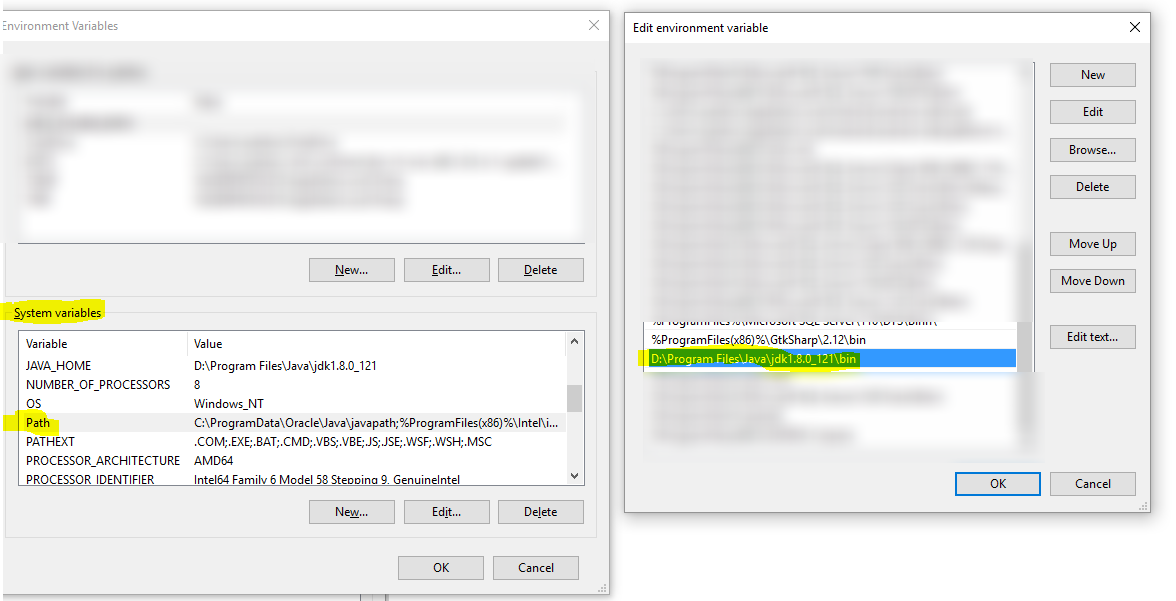

мой коллега решил проблему. Хотя Java, казалось, работал нормально (ref. изображение), Искра пути Java пыталась прочитать, была неправильной с дополнительным \bin в конце. Когда это было удалено, Искра начала работать! @gonbe, большое спасибо за ваши усилия, чтобы помочь!

У меня была подобная ошибка. Я исправил его после следующих изменений:

- в системном пути было несколько путей Java/bin. Поэтому я исправил их, чтобы отразить один Java / Bin, который синхронизирован с JAVA_HOME

- добавлено C:Windows\system32 к системной переменной Path.

- мой Java_Home и java.exe указывал разные места. Я их починил.

теперь все работает.

Спасибо, ребята.

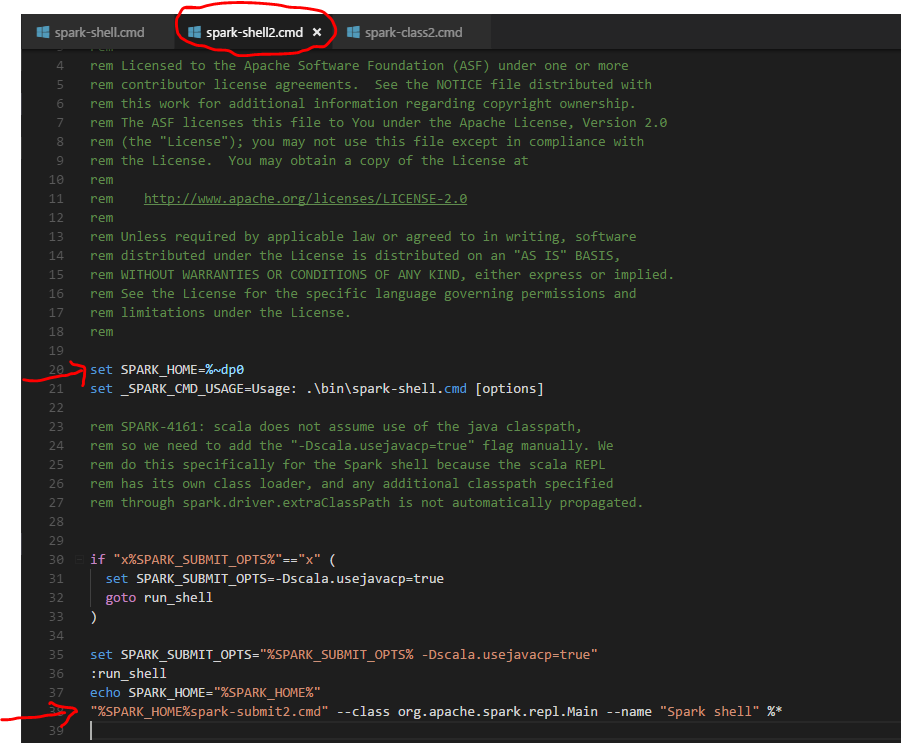

(Я не пользователь Windows Spark) Искровой снаряд.cmd для исходного кода Windows ожидает, что команда " cmd " доступна в PATH.

https://github.com/apache/spark/blob/master/bin/spark-shell.cmd

попробуйте добавить каталог, содержащий " cmd.exe" в переменной среды PATH? Расположение каталога отображается в строке заголовка на снимке экрана, а настройка переменной среды может быть выполнена с помощью панели управления.

Проверьте значения в JAVA_HOME и убедитесь, что он указывает на правильное значение. Добавьте %JAVA_HOME% / bin в значение пути. После модификации закройте командную строку и перезапустите ее. Напишите spark-shell и он будет работать.

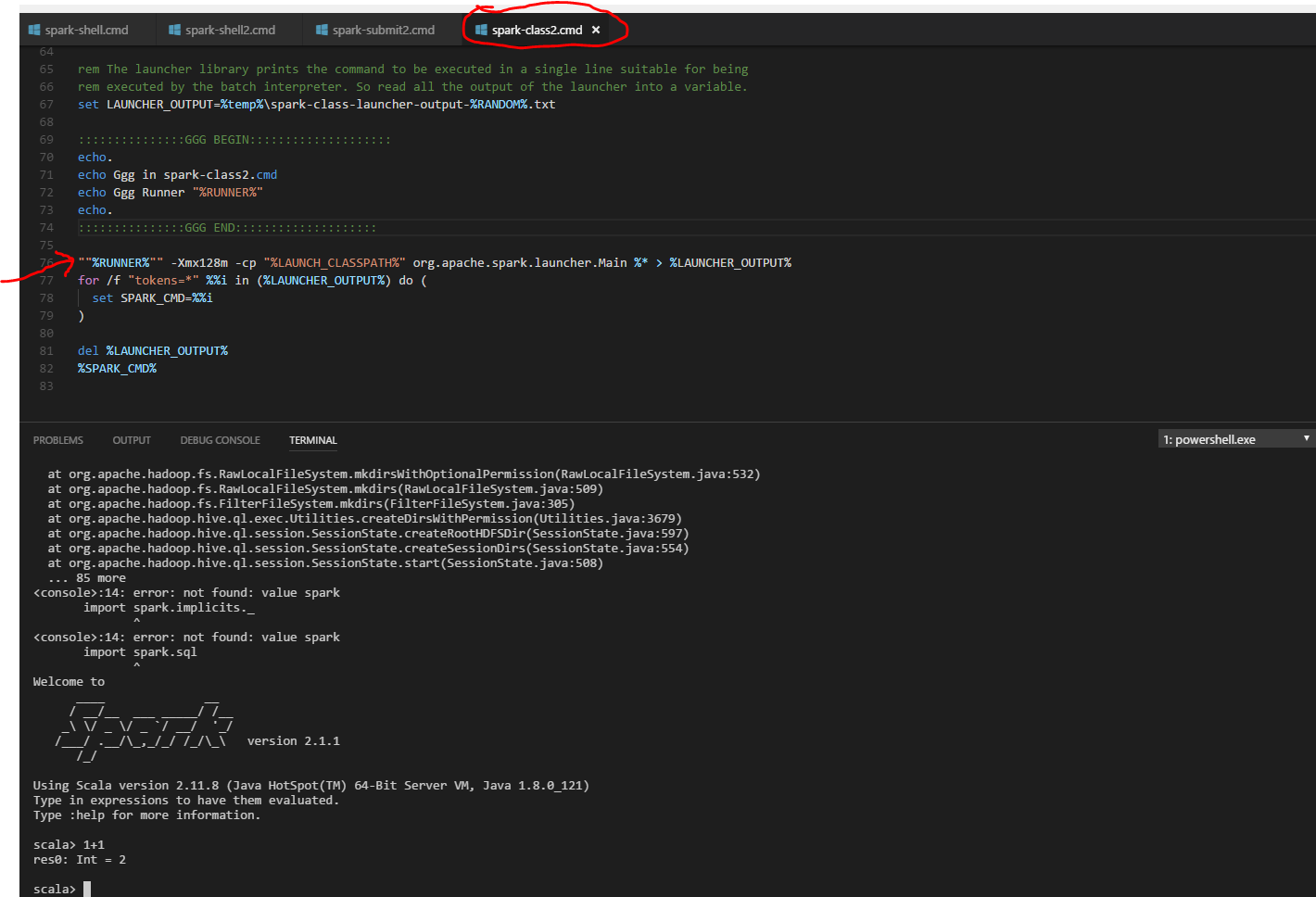

все мои переменные были в порядке, поэтому я решил отладить скрипты и нашел в "spark-class2.cmd" и поставить еще одну пару кавычек в " %RUNNERS%". ДО "%RUNNER% "- Xmx128m-cp" %LAUNCH_CLASSPATH%".... ПОСЛЕ ""%RUNNER% ""- Xmx128m-cp " %LAUNCH_CLASSPATH%"....

для моего случая у меня была аналогичная проблема. Мне нужно было кое-что исправить.

1 - Проверить переменной JAVA_HOME правильно на обоих местах;

2 - тогда мне пришлось изменить следующие строки spark-2.1.1-bin-hadoop2.7 \ bin.

- добавьте дополнительные кавычки вокруг " %RUNNER%". Так что это будет похоже ""%RUNNER%""

- выполнить .\ spark-shell.УМК еще раз.

Я получил ту же ошибку при выполнении Spark-shell в командной строке.

Я пробовал все, что упоминалось выше, но не смог решить проблему.

Итак, наконец я добавил :C:\Windows\System32 "в переменной" PATH " системной переменной и она работала.

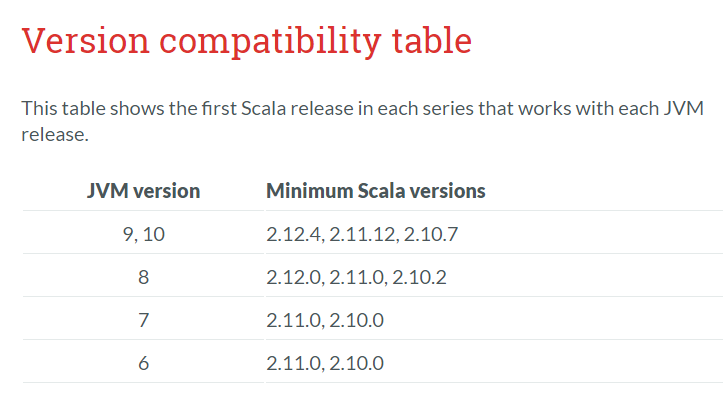

проверьте версию java jdk и версию scala в соответствии с приведенной ниже таблицей совместимости версий: