Тема модели: перекрестная проверка с loglikelihood или недоумение

Я кластеризация документов с использованием тематического моделирования. Мне нужно придумать оптимальную тему. Итак, я решил сделать десятикратную перекрестную проверку с темами 10, 20,...60.

Я разделил свой корпус на десять партий и отложил одну партию для набора несогласных. Я запустил скрытое распределение Дирихле (LDA), используя девять пакетов (всего 180 документов) с темами от 10 до 60. Теперь я должен вычислить недоумение или лог-вероятность для набора несогласия.

Я нашел код С одной из дискуссионных сессий CV. Я действительно не понимаю несколько строк кода ниже. У меня есть DTM-матрица, использующая набор удержаний (20 документов). Но я не знаю, как вычислить недоумение или лог-вероятность этого набора несогласия.

вопросы:

-

может ли кто-нибудь объяснить мне, что здесь означает seq(2, 100, by =1)? Кроме того, что означает AssociatedPress[21:30]? Что здесь делает функция(k)?

best.model <- lapply(seq(2, 100, by=1), function(k){ LDA(AssociatedPress[21:30,], k) }) если я хочу рассчитать недоумение или лог вероятность набора удержания, называемого dtm, есть ли лучший код? Я знаю, что есть

perplexity()иlogLik()функции, но поскольку я новичок, я не могу понять, как реализовать его с помощью моей матрицы удержания, называемой dtm.как я могу сделать десятикратную перекрестную проверку с моим корпусом, содержащим 200 документов? Есть ли существующий код, который я могу вызвать? Я нашел

caretдля этой цели, но снова этого тоже не могу понять.

2 ответов

принятый ответ на этот вопрос хорош, но на самом деле он не касается того, как оценить недоумение в наборе данных проверки и как использовать перекрестную проверку.

использование недоумения для простой проверки

потерянность является мерой того, насколько хорошо вероятностная модель соответствует новому набору данных. В topicmodels R пакет это просто, чтобы соответствовать с perplexity функция, которая принимает в качестве аргументов ранее подходящую модель темы и новый набор данных, и возвращает одно число. Чем ниже, тем лучше.

например, разделение AssociatedPress данные в обучающий набор (75% строк) и набор проверки (25% строк):

# load up some R packages including a few we'll need later

library(topicmodels)

library(doParallel)

library(ggplot2)

library(scales)

data("AssociatedPress", package = "topicmodels")

burnin = 1000

iter = 1000

keep = 50

full_data <- AssociatedPress

n <- nrow(full_data)

#-----------validation--------

k <- 5

splitter <- sample(1:n, round(n * 0.75))

train_set <- full_data[splitter, ]

valid_set <- full_data[-splitter, ]

fitted <- LDA(train_set, k = k, method = "Gibbs",

control = list(burnin = burnin, iter = iter, keep = keep) )

perplexity(fitted, newdata = train_set) # about 2700

perplexity(fitted, newdata = valid_set) # about 4300

недоумение выше для набора проверки, чем набор обучения, потому что темы были оптимизированы на основе набора обучения.

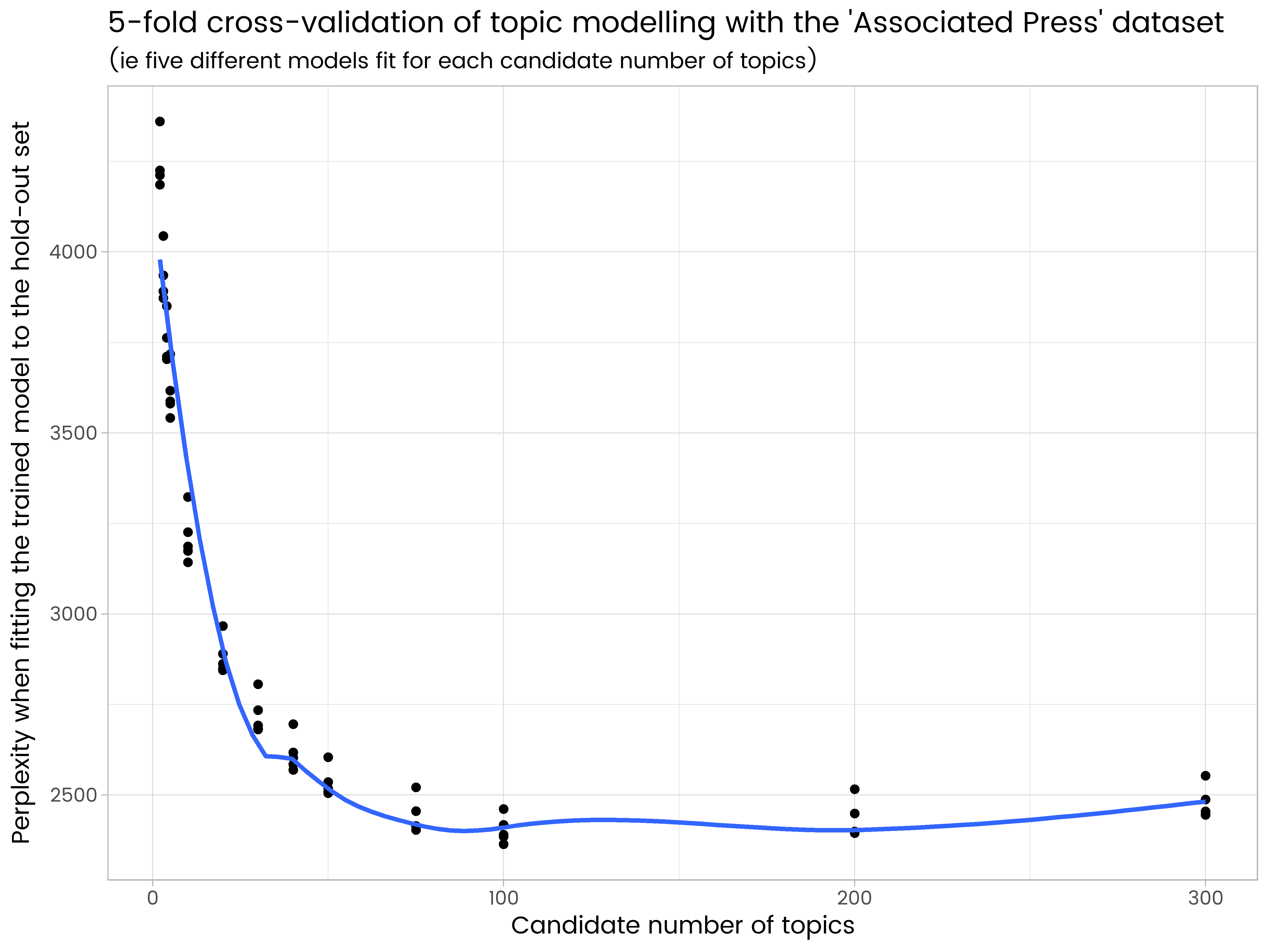

используя недоумение и перекрестную проверку, чтобы определить большое количество тем

расширение эта идея перекрестной проверки проста. Разделите данные на различные подмножества (скажем, 5), и каждое подмножество получит один поворот как набор проверки и четыре поворота как часть набора обучения. Однако это действительно вычислительно интенсивно, особенно при опробовании большего количества тем.

вы могли бы использовать caret чтобы сделать это, но я подозреваю, что он еще не обрабатывает тему моделирования. В любом случае, это то, что я предпочитаю делать сам, чтобы быть уверенным, я понять, что происходит.

код ниже, даже с параллельной обработкой на 7 логических процессорах, занял 3,5 часа, чтобы запустить на моем ноутбуке:

#----------------5-fold cross-validation, different numbers of topics----------------

# set up a cluster for parallel processing

cluster <- makeCluster(detectCores(logical = TRUE) - 1) # leave one CPU spare...

registerDoParallel(cluster)

# load up the needed R package on all the parallel sessions

clusterEvalQ(cluster, {

library(topicmodels)

})

folds <- 5

splitfolds <- sample(1:folds, n, replace = TRUE)

candidate_k <- c(2, 3, 4, 5, 10, 20, 30, 40, 50, 75, 100, 200, 300) # candidates for how many topics

# export all the needed R objects to the parallel sessions

clusterExport(cluster, c("full_data", "burnin", "iter", "keep", "splitfolds", "folds", "candidate_k"))

# we parallelize by the different number of topics. A processor is allocated a value

# of k, and does the cross-validation serially. This is because it is assumed there

# are more candidate values of k than there are cross-validation folds, hence it

# will be more efficient to parallelise

system.time({

results <- foreach(j = 1:length(candidate_k), .combine = rbind) %dopar%{

k <- candidate_k[j]

results_1k <- matrix(0, nrow = folds, ncol = 2)

colnames(results_1k) <- c("k", "perplexity")

for(i in 1:folds){

train_set <- full_data[splitfolds != i , ]

valid_set <- full_data[splitfolds == i, ]

fitted <- LDA(train_set, k = k, method = "Gibbs",

control = list(burnin = burnin, iter = iter, keep = keep) )

results_1k[i,] <- c(k, perplexity(fitted, newdata = valid_set))

}

return(results_1k)

}

})

stopCluster(cluster)

results_df <- as.data.frame(results)

ggplot(results_df, aes(x = k, y = perplexity)) +

geom_point() +

geom_smooth(se = FALSE) +

ggtitle("5-fold cross-validation of topic modelling with the 'Associated Press' dataset",

"(ie five different models fit for each candidate number of topics)") +

labs(x = "Candidate number of topics", y = "Perplexity when fitting the trained model to the hold-out set")

мы видим в результатах, что 200 тем слишком много и имеет некоторые переборки, и 50 слишком мало. Из числа испытанных тем 100 является лучшим, с наименьшим средним недоумением на пяти различных наборах удержания.

я написал ответ на CV, на который вы ссылаетесь, вот немного подробнее:

seq(2, 100, by =1)просто создает последовательность чисел от 2 до 100 по одному, так 2, 3, 4, 5, ... 100. Это количество тем, которые я хочу использовать в моделях. Одна модель с 2 темами, другая с 3 темами, другая с 4 темами и так далее до 100 тем.AssociatedPress[21:30]- это просто подмножество встроенных данных вtopicmodelsпакета. Я просто использовал подмножество в этот пример, чтобы он работал быстрее.

Что касается общего вопроса об оптимальных номерах тем, я теперь следую примеру Мартина Понвайзер о выборе модели гармоническим средним (4.3.3 в своей диссертации, которая здесь:http://epub.wu.ac.at/3558/1/main.pdf). Вот как я это делаю на данный момент:

library(topicmodels)

#

# get some of the example data that's bundled with the package

#

data("AssociatedPress", package = "topicmodels")

harmonicMean <- function(logLikelihoods, precision=2000L) {

library("Rmpfr")

llMed <- median(logLikelihoods)

as.double(llMed - log(mean(exp(-mpfr(logLikelihoods,

prec = precision) + llMed))))

}

# The log-likelihood values are then determined by first fitting the model using for example

k = 20

burnin = 1000

iter = 1000

keep = 50

fitted <- LDA(AssociatedPress[21:30,], k = k, method = "Gibbs",control = list(burnin = burnin, iter = iter, keep = keep) )

# where keep indicates that every keep iteration the log-likelihood is evaluated and stored. This returns all log-likelihood values including burnin, i.e., these need to be omitted before calculating the harmonic mean:

logLiks <- fitted@logLiks[-c(1:(burnin/keep))]

# assuming that burnin is a multiple of keep and

harmonicMean(logLiks)

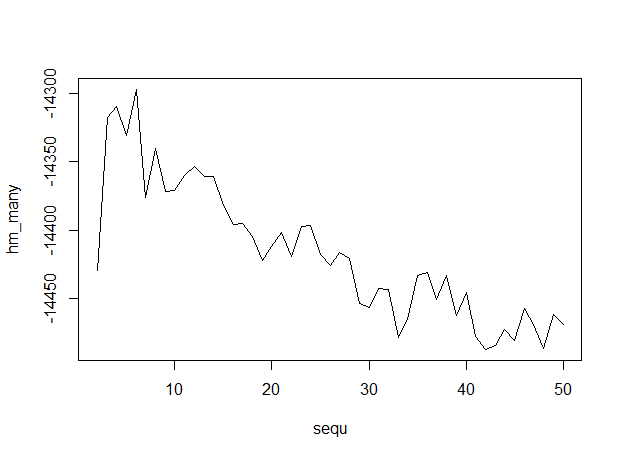

Итак, чтобы сделать это над последовательностью тематических моделей с различным количеством тем...

# generate numerous topic models with different numbers of topics

sequ <- seq(2, 50, 1) # in this case a sequence of numbers from 1 to 50, by ones.

fitted_many <- lapply(sequ, function(k) LDA(AssociatedPress[21:30,], k = k, method = "Gibbs",control = list(burnin = burnin, iter = iter, keep = keep) ))

# extract logliks from each topic

logLiks_many <- lapply(fitted_many, function(L) L@logLiks[-c(1:(burnin/keep))])

# compute harmonic means

hm_many <- sapply(logLiks_many, function(h) harmonicMean(h))

# inspect

plot(sequ, hm_many, type = "l")

# compute optimum number of topics

sequ[which.max(hm_many)]

## 6

Это место выходные данные, с количеством тем вдоль оси x, указывая, что 6 тем является оптимальным.

Это место выходные данные, с количеством тем вдоль оси x, указывая, что 6 тем является оптимальным.

перекрестная проверка тематических моделей довольно хорошо документирована в документах, которые поставляются с пакетом, см. здесь, например:http://cran.r-project.org/web/packages/topicmodels/vignettes/topicmodels.pdf попробуйте, а затем вернитесь с более конкретным вопросом о кодировании CV с тематическими моделями.