Установка распределения Weibull с использованием Scipy

Я пытаюсь воссоздать установку распределения максимального правдоподобия, я уже могу сделать это в Matlab и R, но теперь я хочу использовать scipy. В частности, я хотел бы оценить параметры распределения Вейбулла для моего набора данных.

Я попытался это:

import scipy.stats as s

import numpy as np

import matplotlib.pyplot as plt

def weib(x,n,a):

return (a / n) * (x / n)**(a - 1) * np.exp(-(x / n)**a)

data = np.loadtxt("stack_data.csv")

(loc, scale) = s.exponweib.fit_loc_scale(data, 1, 1)

print loc, scale

x = np.linspace(data.min(), data.max(), 1000)

plt.plot(x, weib(x, loc, scale))

plt.hist(data, data.max(), normed=True)

plt.show()

и

(2.5827280639441961, 3.4955032285727947)

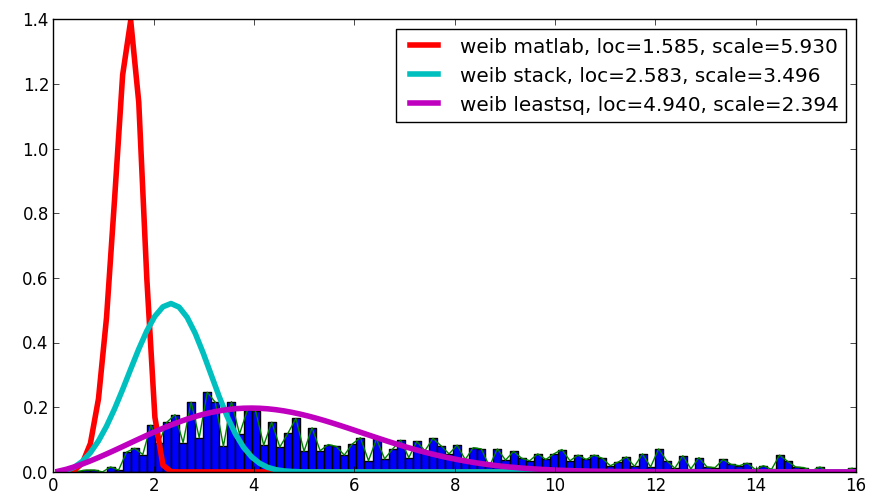

и распределение, которое выглядит так:

Я использую exponweib после прочтения этого http://www.johndcook.com/distributions_scipy.html. Я также пробовал другие функции Weibull в scipy (на всякий случай!).

в Matlab (с помощью инструмента установки дистрибутива-см. скриншот) и в R (с помощью функции массовой библиотеки fitdistr и пакет GAMLSS) я получаю параметры a (loc) и b (масштаб), больше похожие на 1.58463497 5.93030013. Я считаю, что все три метода используют метод максимального правдоподобия для распределения примерка.

я опубликовал свои данные здесь если вы хотите, чтобы пойти! И для полноты я использую Python 2.7.5, Scipy 0.12.0, R 2.15.2 и Matlab 2012b.

Почему я получаю разные результаты!?

8 ответов

Я предполагаю, что вы хотите оценить параметр формы и масштаб распределения Вейбулла, сохраняя фиксированное местоположение. Исправление loc предполагает, что значения ваших данных и распределения положительны с нижней границей в нуле.

floc=0 сохраняет местоположение фиксированным на нуле,f0=1 сохраняет первый параметр формы экспоненциального Вейбулла фиксированным на одном.

>>> stats.exponweib.fit(data, floc=0, f0=1)

[1, 1.8553346917584836, 0, 6.8820748596850905]

>>> stats.weibull_min.fit(data, floc=0)

[1.8553346917584836, 0, 6.8820748596850549]

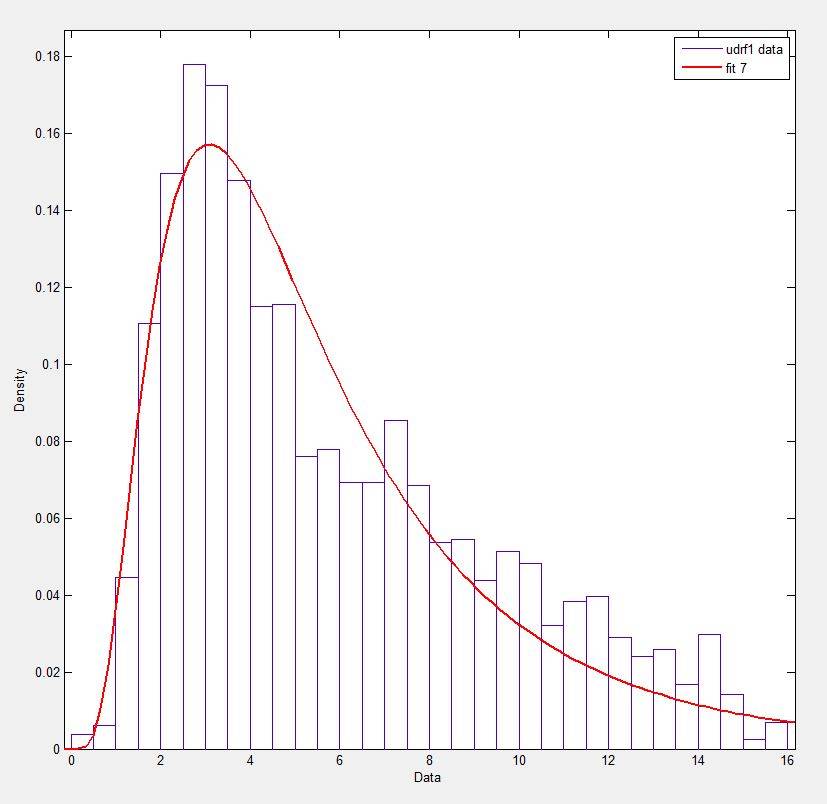

пригодный по сравнению с гистограммой выглядит нормально, но не очень хорошо. Этот оценки параметров немного выше, чем те, которые вы упомянули, из R и matlab.

обновление

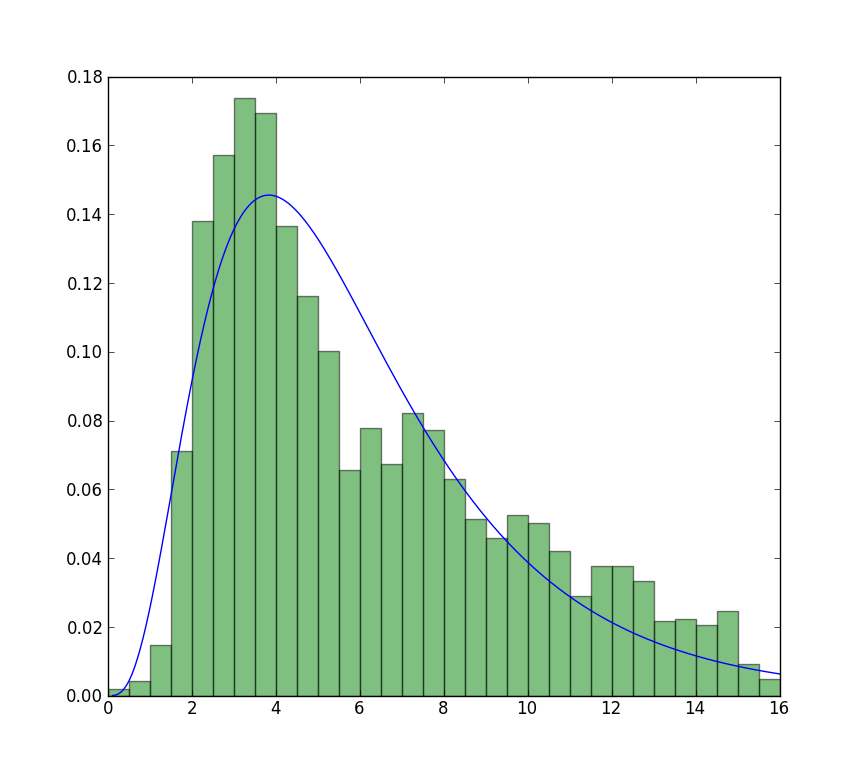

ближе всего я могу добраться до графика, который теперь доступен, с неограниченной подгонкой, но с использованием начальных значений. Сюжет еще менее пиковый. Примечание значения в форме, которые не имеют F в передней используются в качестве начальных значений.

>>> from scipy import stats

>>> import matplotlib.pyplot as plt

>>> plt.plot(data, stats.exponweib.pdf(data, *stats.exponweib.fit(data, 1, 1, scale=02, loc=0)))

>>> _ = plt.hist(data, bins=np.linspace(0, 16, 33), normed=True, alpha=0.5);

>>> plt.show()

легко проверить, какой результат является истинным MLE, просто нужна простая функция для вычисления вероятности журнала:

>>> def wb2LL(p, x): #log-likelihood

return sum(log(stats.weibull_min.pdf(x, p[1], 0., p[0])))

>>> adata=loadtxt('/home/user/stack_data.csv')

>>> wb2LL(array([6.8820748596850905, 1.8553346917584836]), adata)

-8290.1227946678173

>>> wb2LL(array([5.93030013, 1.57463497]), adata)

-8410.3327470347667

результат fit метод exponweib и R fitdistr (@Warren) лучше и имеет более высокую вероятность журнала. Скорее всего, это будет истинный MLE. Неудивительно, что результат от GAMLSS отличается. Это совершенно другая статистическая модель: обобщенная аддитивная модель.

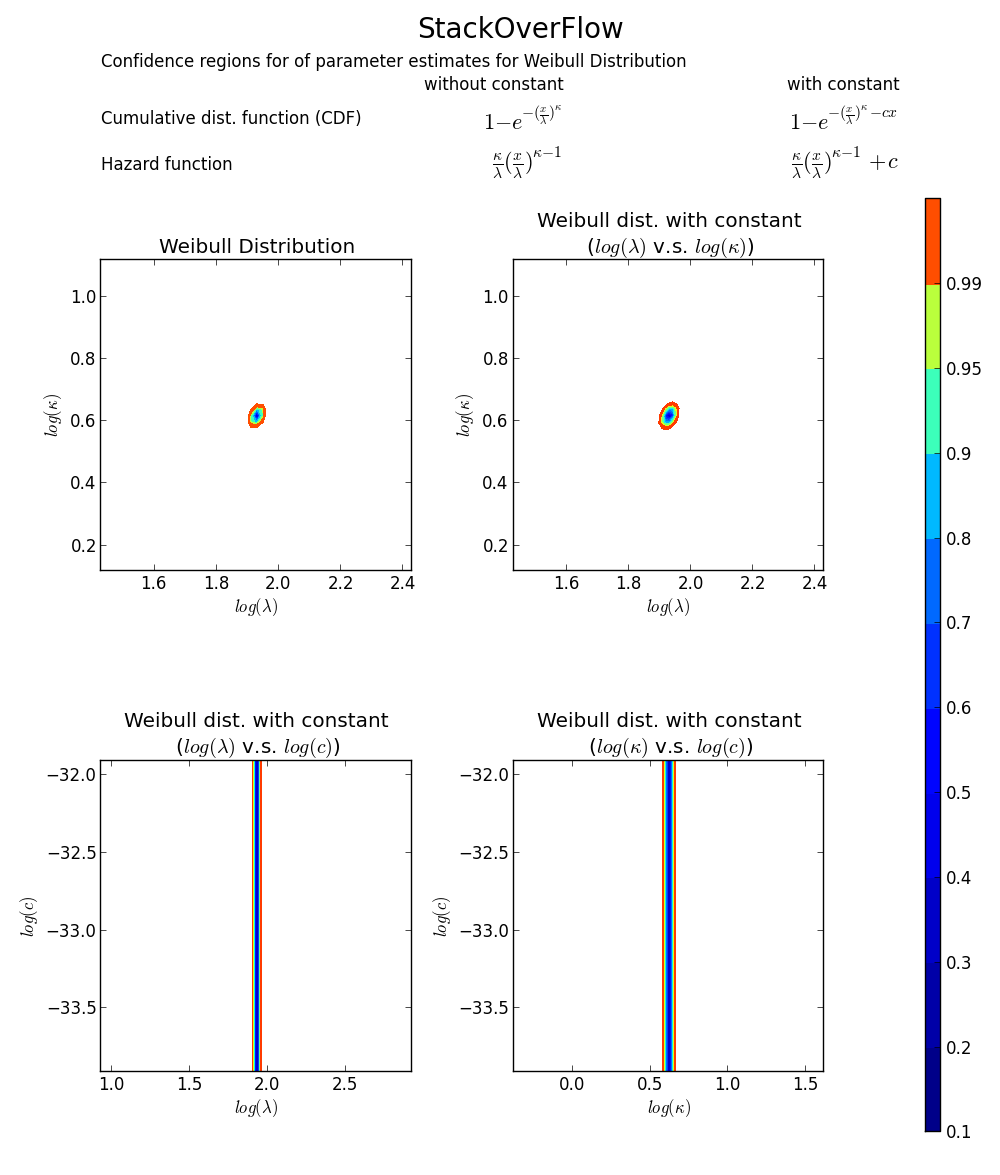

все еще не убедил? Мы можем нарисовать 2D доверие ограничьте сюжет вокруг MLE, см. книгу Микера и Эскобара для деталей).

снова это подтверждает, что array([6.8820748596850905, 1.8553346917584836]) - правильный ответ, так как loglikelihood ниже любой другой точки в пространстве параметров. Примечание:

>>> log(array([6.8820748596850905, 1.8553346917584836]))

array([ 1.92892018, 0.61806511])

BTW1, mle fit может не соответствовать гистограмме распределения плотно. Простой способ думать о MLE заключается в том, что MLE является наиболее вероятной оценкой параметра с учетом наблюдаемых данных. Он не должен визуально соответствовать гистограмме хорошо, что будет что-то минимизации среднеквадратической ошибки.

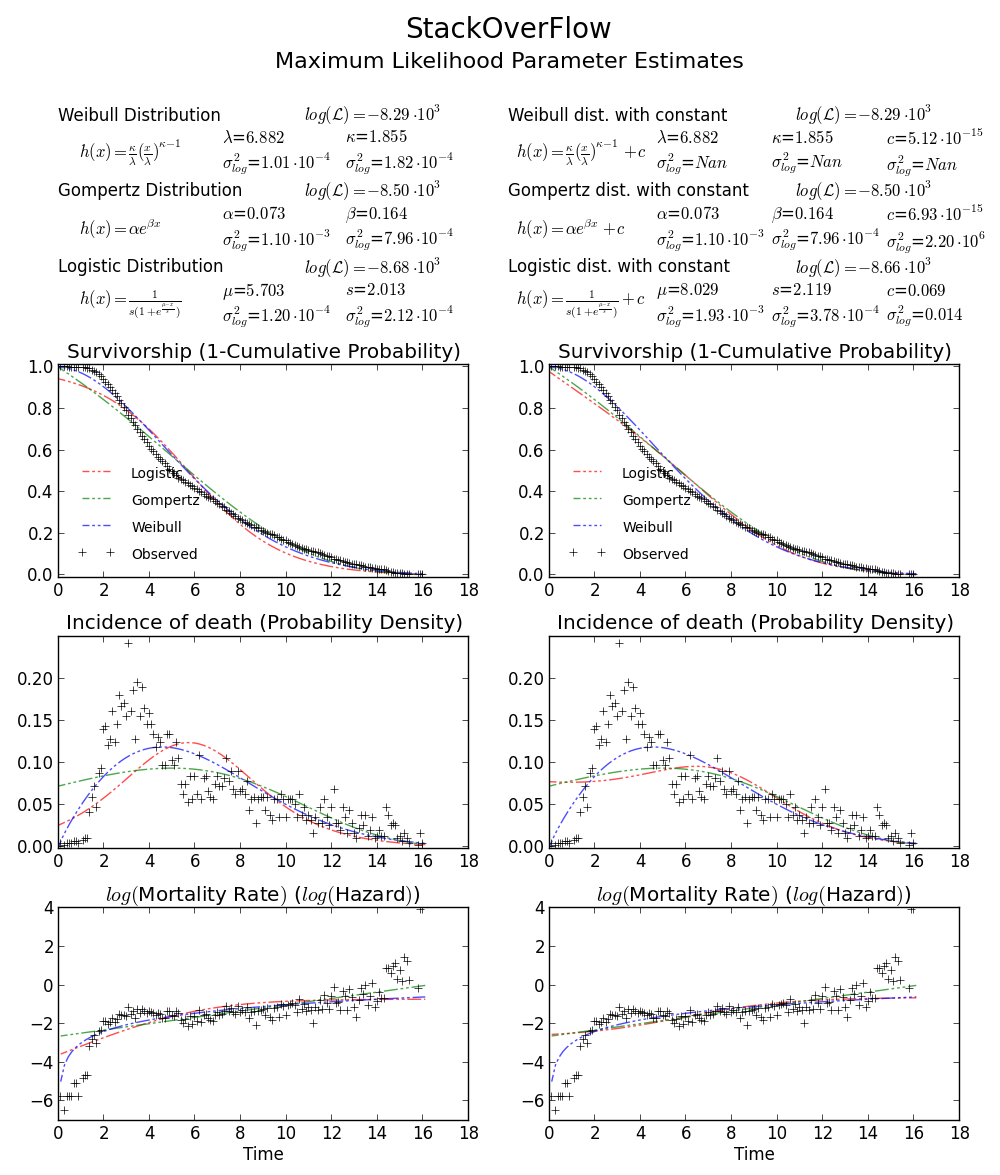

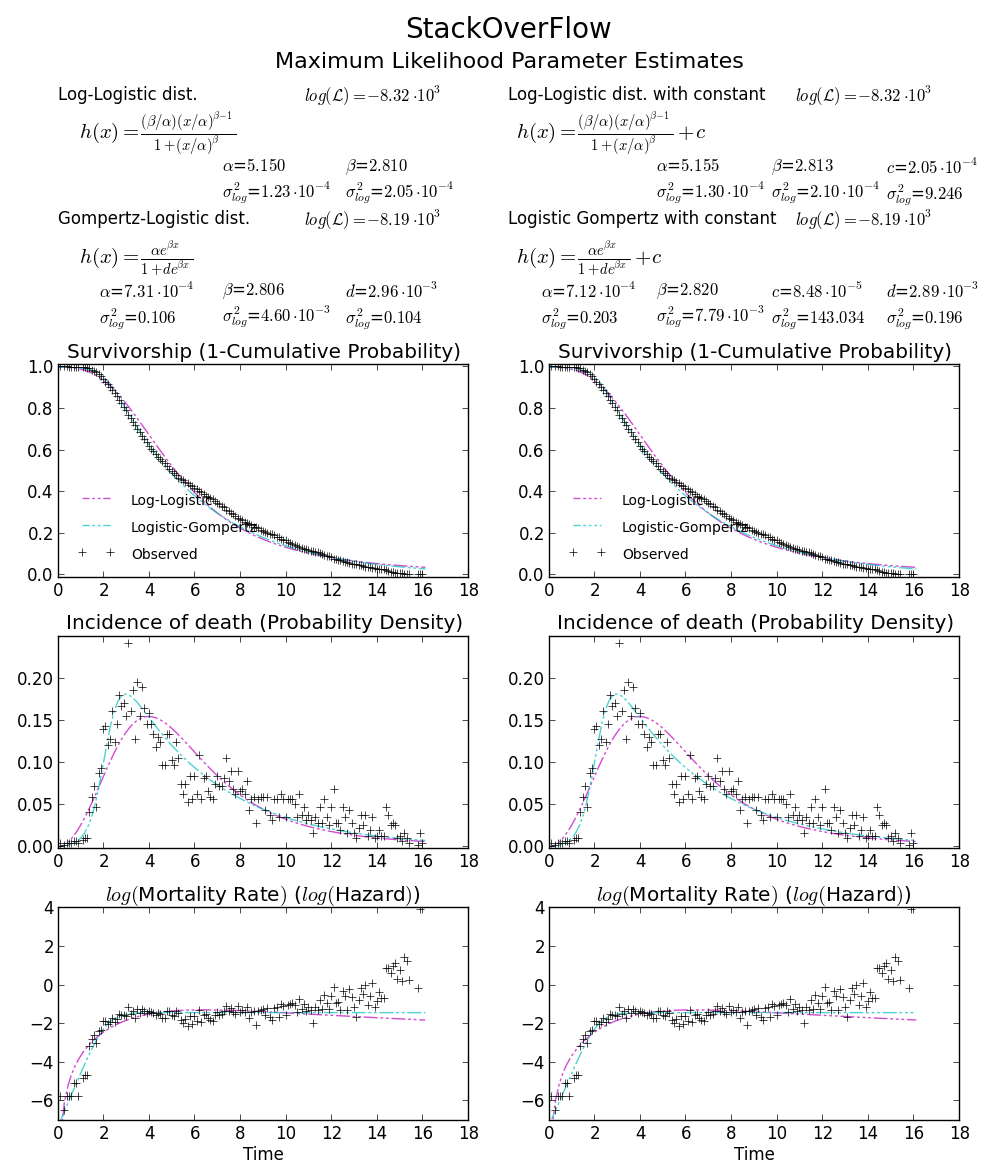

BTW2, ваши данные кажутся лептокуртическими и левосторонними, что означает, что распределение Weibull может не соответствовать вашим данным. Попробуйте, например, Gompertz-Logistic, который улучшает лог-вероятность еще на 100.

Ура!

Ура!

мне было любопытно ваш вопрос, и, несмотря на то, что это не ответ, он сравнивает Matlab результат с вашим результатом и результатом, используя leastsq, который показал лучшую корреляцию с данными:

код выглядит следующим образом:

import scipy.stats as s

import numpy as np

import matplotlib.pyplot as plt

import numpy.random as mtrand

from scipy.integrate import quad

from scipy.optimize import leastsq

## my distribution (Inverse Normal with shape parameter mu=1.0)

def weib(x,n,a):

return (a / n) * (x / n)**(a-1) * np.exp(-(x/n)**a)

def residuals(p,x,y):

integral = quad( weib, 0, 16, args=(p[0],p[1]) )[0]

penalization = abs(1.-integral)*100000

return y - weib(x, p[0],p[1]) + penalization

#

data = np.loadtxt("stack_data.csv")

x = np.linspace(data.min(), data.max(), 100)

n, bins, patches = plt.hist(data,bins=x, normed=True)

binsm = (bins[1:]+bins[:-1])/2

popt, pcov = leastsq(func=residuals, x0=(1.,1.), args=(binsm,n))

loc, scale = 1.58463497, 5.93030013

plt.plot(binsm,n)

plt.plot(x, weib(x, loc, scale),

label='weib matlab, loc=%1.3f, scale=%1.3f' % (loc, scale), lw=4.)

loc, scale = s.exponweib.fit_loc_scale(data, 1, 1)

plt.plot(x, weib(x, loc, scale),

label='weib stack, loc=%1.3f, scale=%1.3f' % (loc, scale), lw=4.)

plt.plot(x, weib(x,*popt),

label='weib leastsq, loc=%1.3f, scale=%1.3f' % tuple(popt), lw=4.)

plt.legend(loc='upper right')

plt.show()

Я знаю, что это старый пост, но я только что столкнулся с подобной проблемой, и эта тема помогла мне ее решить. Думал, что мое решение может быть полезно для других, таких как я:

# Fit Weibull function, some explanation below

params = stats.exponweib.fit(data, floc=0, f0=1)

shape = params[1]

scale = params[3]

print 'shape:',shape

print 'scale:',scale

#### Plotting

# Histogram first

values,bins,hist = plt.hist(data,bins=51,range=(0,25),normed=True)

center = (bins[:-1] + bins[1:]) / 2.

# Using all params and the stats function

plt.plot(center,stats.exponweib.pdf(center,*params),lw=4,label='scipy')

# Using my own Weibull function as a check

def weibull(u,shape,scale):

'''Weibull distribution for wind speed u with shape parameter k and scale parameter A'''

return (shape / scale) * (u / scale)**(shape-1) * np.exp(-(u/scale)**shape)

plt.plot(center,weibull(center,shape,scale),label='Wind analysis',lw=2)

plt.legend()

дополнительная информация, которая помогла мне понять:

функция scipy Weibull может принимать четыре входных параметра: (a,c),loc и масштаб. Вы хотите исправить loc и первый параметр формы (a), это делается с помощью floc=0, f0=1. Затем подгонка даст вам параметры c и масштаб, где c соответствует форме параметр двухпараметрического распределения Вейбулла (часто используется при анализе данных ветра) и масштаб соответствует его масштабному коэффициенту.

из docs:

exponweib.pdf(x, a, c) =

a * c * (1-exp(-x**c))**(a-1) * exp(-x**c)*x**(c-1)

Если a равно 1, то

exponweib.pdf(x, a, c) =

c * (1-exp(-x**c))**(0) * exp(-x**c)*x**(c-1)

= c * (1) * exp(-x**c)*x**(c-1)

= c * x **(c-1) * exp(-x**c)

из этого отношение к функции Вейбулла "анализ ветра" должно быть более ясным

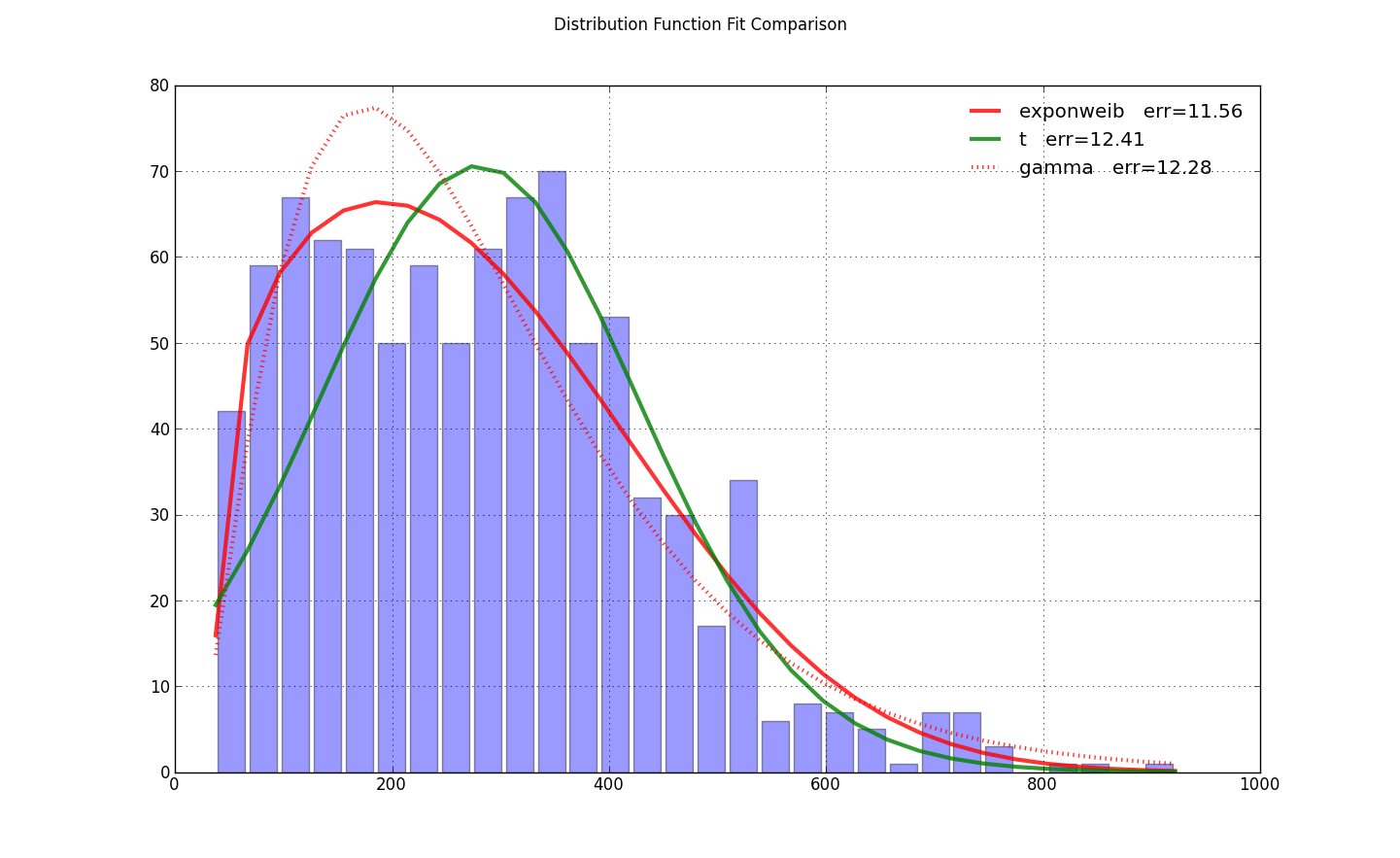

у меня была та же проблема, но я нашел эту настройку loc=0 на exponweib.fit загрунтовал насос для оптимизации. Это было все, что требовалось от @user333700 ответ. Я не мог загрузить ваши данные - ваши данных указывает на изображение, а не на данные. Поэтому вместо этого я провел тест на своих данных:

import scipy.stats as ss

import matplotlib.pyplot as plt

import numpy as np

N=30

counts, bins = np.histogram(x, bins=N)

bin_width = bins[1]-bins[0]

total_count = float(sum(counts))

f, ax = plt.subplots(1, 1)

f.suptitle(query_uri)

ax.bar(bins[:-1]+bin_width/2., counts, align='center', width=.85*bin_width)

ax.grid('on')

def fit_pdf(x, name='lognorm', color='r'):

dist = getattr(ss, name) # params = shape, loc, scale

# dist = ss.gamma # 3 params

params = dist.fit(x, loc=0) # 1-day lag minimum for shipping

y = dist.pdf(bins, *params)*total_count*bin_width

sqerror_sum = np.log(sum(ci*(yi - ci)**2. for (ci, yi) in zip(counts, y)))

ax.plot(bins, y, color, lw=3, alpha=0.6, label='%s err=%3.2f' % (name, sqerror_sum))

return y

colors = ['r-', 'g-', 'r:', 'g:']

for name, color in zip(['exponweib', 't', 'gamma'], colors): # 'lognorm', 'erlang', 'chi2', 'weibull_min',

y = fit_pdf(x, name=name, color=color)

ax.legend(loc='best', frameon=False)

plt.show()

было несколько ответов на это уже здесь и в других местах. likt in распределение Вейбулла и данные на одном рисунке (с numpy и scipy)

Мне все еще потребовалось некоторое время, чтобы придумать пример чистой игрушки, поэтому я подумал, что было бы полезно опубликовать.

from scipy import stats

import matplotlib.pyplot as plt

#input for pseudo data

N = 10000

Kappa_in = 1.8

Lambda_in = 10

a_in = 1

loc_in = 0

#Generate data from given input

data = stats.exponweib.rvs(a=a_in,c=Kappa_in, loc=loc_in, scale=Lambda_in, size = N)

#The a and loc are fixed in the fit since it is standard to assume they are known

a_out, Kappa_out, loc_out, Lambda_out = stats.exponweib.fit(data, f0=a_in,floc=loc_in)

#Plot

bins = range(51)

fig = plt.figure()

ax = fig.add_subplot(1, 1, 1)

ax.plot(bins, stats.exponweib.pdf(bins, a=a_out,c=Kappa_out,loc=loc_out,scale = Lambda_out))

ax.hist(data, bins = bins , normed=True, alpha=0.5)

ax.annotate("Shape: $k = %.2f$ \n Scale: $\lambda = %.2f$"%(Kappa_out,Lambda_out), xy=(0.7, 0.85), xycoords=ax.transAxes)

plt.show()

порядок loc и масштаба перепутан в коде:

plt.plot(x, weib(x, scale, loc))

сначала должен появиться параметр scale.

в функции fit есть 3 параметра для рассмотрения:

параметры формы: в этом случае, у нас есть два параметра формы, которые могут быть исправлены в соответствии с F0 и F1. (Попробуйте сами!). Обычно имя параметра обозначается f%d, где d-номер фигуры.

параметр location: используйте floc, чтобы исправить это. Если ты ... --12-->не исправить флок, среднее значение данных выводится как линия контроля.

параметр масштаба: используйте fscale, чтобы исправить это.

возврат любого fit выходит в этом порядке.

следуя по строкам @Peter9192, я нашел наиболее подходящий для CDF Weibull ~20-30 образцов данных, используя следующее:

_,gamma,_alpha=scipy.stats.exponweib.fit(data,floc=0,f0=1)

формула для CDF:

1-np.exp(-np.power(x/alpha,gamma))

Значения сведения я оценил с помощью метода оценки K - M, соответствующего Вейбуллу распределение дало мне хорошие ценности.

чтобы исправить a как 1, I не find loc=0, scale=1 как лучший метод, как вы можете ясно видеть в 4 возвращаемых значениях параметров. Во-вторых, используя гамму, Альфа из нее не выдавала правильного вейбулловского значения.

наконец, я подтвердил, какой метод работает лучше всего, вычисляя среднее значение распределения Вейбулла, используя:

Mean=alpha*scipy.special.gamma(1+(1/gamma))

Значений у меня соответствует моей заявке.

вы можете проверить формулы mean & CDF здесь для справки:https://en.m.wikipedia.org/wiki/Weibull_distribution