Что означает" relu " в tf.НН.Релу?

в своем документация по API, Он говорит "вычисляет выпрямляется линейным".

Это Re (ctified) L(inear)... что же такое U?

2 ответов

Re (ctified) L(inear) (U) nit

обычно слой в нейронной сети имеет некоторый вход, скажем вектор, и умножает его на весовую матрицу, в результате чего т. е. снова в векторе.

каждое значение в результате (обычно float) затем считается выходом. Однако большинство слоев в нейронных сетях в настоящее время связаны с нелинейностями, поэтому дополнительная функция, которая, можно сказать, добавляет сложности этим выходным значениям. Долго они были sigmoids и tanhs.

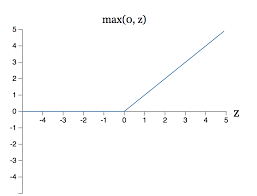

но в последнее время люди используют функцию, которая приводит к 0, если вход отрицательный, и сам вход, если этот вход 0 или положительный. Эта конкретная дополнительная функция (или лучше "функция активации") называется relu.

на верхней части ответа Friesel, я хотел бы добавить две важные характеристики Релу.

1. Она не дифференцируема.

график Релу: он заостренный, а не изогнутый.

определяется как f(x) = max(0,x)

поэтому она не дифференцируема.

2. Производная от ReLU очень проста! Проще, чем сигмоид, который x(1-x).

The derivative of ReLU:

1 if x > 0

0 otherwise

Это самая простая нелинейная функция, которую мы используем в основном на скрытых слоях. Подумайте о том, как легко было бы вернуться!