нелинейная подгонка наименьших квадратов python

Я немного не в своей глубине с точки зрения математики, связанной с моей проблемой, поэтому я приношу извинения за любую неправильную номенклатуру.

Я смотрел на использование функции scipy leastsq, но не уверен, что это правильная функция. У меня есть следующее уравнение:

eq = lambda PLP,p0,l0,kd : 0.5*(-1-((p0+l0)/kd) + np.sqrt(4*(l0/kd)+(((l0-p0)/kd)-1)**2))

У меня есть данные (8 наборов) для всех терминов,кроме kd (PLP,p0, l0). Мне нужно найти значение kd нелинейной регрессией приведенного выше уравнения. Из примеров, которые я прочитал, leastsq кажется чтобы не допускать ввода данных, чтобы получить вывод, который мне нужен.

Спасибо за помощь

2 ответов

это голые кости пример того, как использовать scipy.optimize.leastsq:

import numpy as np

import scipy.optimize as optimize

import matplotlib.pylab as plt

def func(kd,p0,l0):

return 0.5*(-1-((p0+l0)/kd) + np.sqrt(4*(l0/kd)+(((l0-p0)/kd)-1)**2))

сумма квадратов residuals функция kd мы пытаемся свести к минимуму:

def residuals(kd,p0,l0,PLP):

return PLP - func(kd,p0,l0)

здесь я генерирую некоторые случайные данные. Вы бы хотели загрузить свои реальные данные здесь.

N=1000

kd_guess=3.5 # <-- You have to supply a guess for kd

p0 = np.linspace(0,10,N)

l0 = np.linspace(0,10,N)

PLP = func(kd_guess,p0,l0)+(np.random.random(N)-0.5)*0.1

kd,cov,infodict,mesg,ier = optimize.leastsq(

residuals,kd_guess,args=(p0,l0,PLP),full_output=True,warning=True)

print(kd)

дает что-то вроде

3.49914274899

это наиболее подходящее значение для kd нашел optimize.leastsq.

здесь мы генерируем значение PLP используя значение для kd мы только что нашел:

PLP_fit=func(kd,p0,l0)

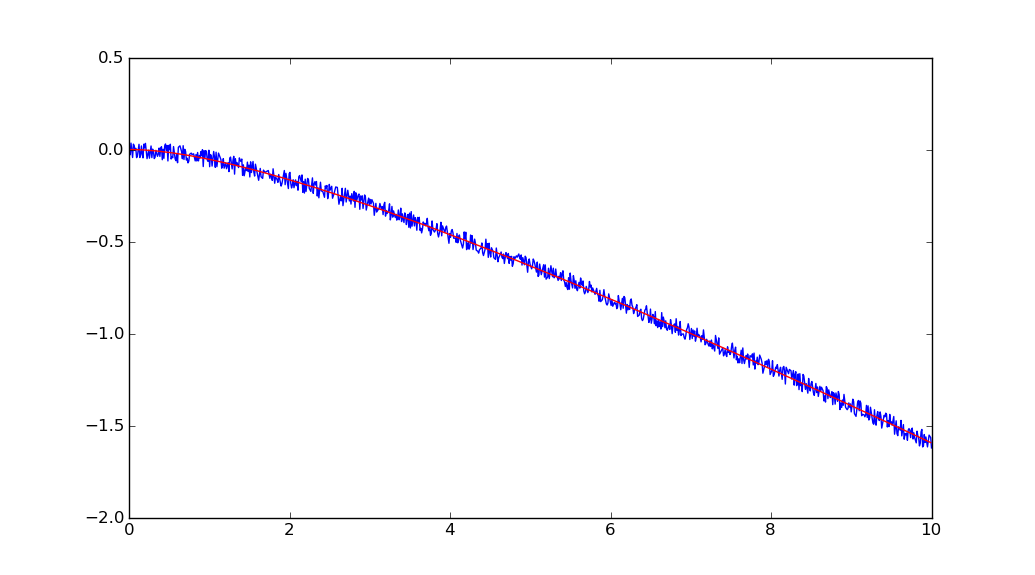

ниже приведен сюжет PLP и p0. Синяя линия-данные, красная линия-кривая наилучшего вписывания.

plt.plot(p0,PLP,'-b',p0,PLP_fit,'-r')

plt.show()

другой вариант-использовать lmfit.

большой пример чтобы вы начали:.

#!/usr/bin/env python

#<examples/doc_basic.py>

from lmfit import minimize, Minimizer, Parameters, Parameter, report_fit

import numpy as np

# create data to be fitted

x = np.linspace(0, 15, 301)

data = (5. * np.sin(2 * x - 0.1) * np.exp(-x*x*0.025) +

np.random.normal(size=len(x), scale=0.2) )

# define objective function: returns the array to be minimized

def fcn2min(params, x, data):

""" model decaying sine wave, subtract data"""

amp = params['amp']

shift = params['shift']

omega = params['omega']

decay = params['decay']

model = amp * np.sin(x * omega + shift) * np.exp(-x*x*decay)

return model - data

# create a set of Parameters

params = Parameters()

params.add('amp', value= 10, min=0)

params.add('decay', value= 0.1)

params.add('shift', value= 0.0, min=-np.pi/2., max=np.pi/2)

params.add('omega', value= 3.0)

# do fit, here with leastsq model

minner = Minimizer(fcn2min, params, fcn_args=(x, data))

kws = {'options': {'maxiter':10}}

result = minner.minimize()

# calculate final result

final = data + result.residual

# write error report

report_fit(result)

# try to plot results

try:

import pylab

pylab.plot(x, data, 'k+')

pylab.plot(x, final, 'r')

pylab.show()

except:

pass

#<end of examples/doc_basic.py>