уменьшение глубины цвета с opencv и LUT

Я хотел бы выполнить уменьшение цвета с помощью масштабирования глубины цвета.

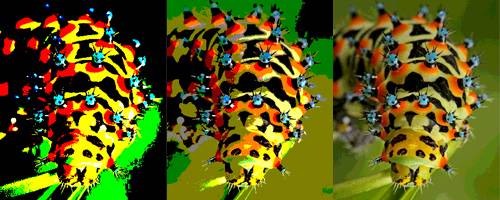

такой пример:

первое изображение-разрешение CGA, второе-EGA, третье-HAM. Я хотел бы сделать это с cv::LUT, потому что я думаю, что это лучший способ сделать это. Я могу сделать с оттенками серого с помощью этого кода:

Mat img = imread("test1.jpg", 0);

uchar* p;

Mat lookUpTable(1, 256, CV_8U);

p = lookUpTable.data;

for( int i = 0; i < 256; ++i)

p[i] = 16 * (i/16)

LUT(img, lookUpTable, reduced);

оригинал:

цвета уменьшена:

но если я попытаюсь сделать это с цветом, я получаю странный результат..

этот код:

imgColor = imread("test1.jpg");

Mat reducedColor;

int n = 16;

for (int i=0; i<256; i++) {

uchar value = floor(i/n) * n;

cout << (int)value << endl;

lut.at<Vec3b>(i)[2]= (value >> 16) & 0xff;

lut.at<Vec3b>(i)[1]= (value >> 8) & 0xff;

lut.at<Vec3b>(i)[0]= value & 0xff;

}

LUT(imgColor, lut, reducedColor);

2 ответов

вы, вероятно, уже перешли, но корень проблемы в том, что вы делаете 16-битный сдвиг на uchar value, который имеет длину всего 8 бит. Даже 8-битный сдвиг в этом случае слишком велик, так как вы сотрете все биты в uchar. То есть тот факт, что cv::LUT документация явно указано, что src должен быть "входной массив 8-битных элементов", что явно не относится к вашему коду. В результате получается, что только Первый канал цвета изображение (синий канал) преобразуется cv::LUT.

лучший способ обойти эти ограничения-разделить цветные изображения по каналам, преобразовать каждый канал отдельно, а затем объединить преобразованные каналы в новое цветное изображение. См. код ниже:

/*

Calculates a table of 256 assignments with the given number of distinct values.

Values are taken at equal intervals from the ranges [0, 128) and [128, 256),

such that both 0 and 255 are always included in the range.

*/

cv::Mat lookupTable(int levels) {

int factor = 256 / levels;

cv::Mat table(1, 256, CV_8U);

uchar *p = table.data;

for(int i = 0; i < 128; ++i) {

p[i] = factor * (i / factor);

}

for(int i = 128; i < 256; ++i) {

p[i] = factor * (1 + (i / factor)) - 1;

}

return table;

}

/*

Truncates channel levels in the given image to the given number of

equally-spaced values.

Arguments:

image

Input multi-channel image. The specific color space is not

important, as long as all channels are encoded from 0 to 255.

levels

The number of distinct values for the channels of the output

image. Output values are drawn from the range [0, 255] from

the extremes inwards, resulting in a nearly equally-spaced scale

where the smallest and largest values are always 0 and 255.

Returns:

Multi-channel images with values truncated to the specified number of

distinct levels.

*/

cv::Mat colorReduce(const cv::Mat &image, int levels) {

cv::Mat table = lookupTable(levels);

std::vector<cv::Mat> c;

cv::split(image, c);

for (std::vector<cv::Mat>::iterator i = c.begin(), n = c.end(); i != n; ++i) {

cv::Mat &channel = *i;

cv::LUT(channel.clone(), table, channel);

}

cv::Mat reduced;

cv::merge(c, reduced);

return reduced;

}

и i и n являются целыми числами, поэтому i/n - целое число. Возможно, вы хотите, чтобы он был преобразован в double ((double)i/n) перед тем, как взять слово и умножить на n?