Запросы занимают слишком много времени в Tomcat 8 в пиковое время

я настроил tomcat со следующими конфигурациями:

<Connector port="8080" protocol="HTTP/1.1"

connectionTimeout="20000"

maxThreads="500"

maxConnections="20000"

acceptCount="150"

etc... />

те же номера для AJP разъем maxThreads=500 и acceptCount="150".

он работает нормально большую часть времени, но в пиковые времена, когда у меня гораздо больше запросов, чем обычно, требуется слишком много времени, чтобы ответить. Иногда выше 15 секунд и в редких случаях тайм-аут. Это может выглядеть нормально, как maxThreads=500 и у меня есть несколько тысяч запросов, однако, по статусу сервера я вижу:

Макс потоки: 500 текущий поток количество: 17 текущий поток занят: 1 держать количество живых сокетов: 1

максимальное число currentThreadCount Я видел до сих пор было 27. Если есть так много соединений, не должен ли tomcat создавать больше потоков (до 500), чтобы реагировать быстрее?

Итак, что я делаю не так? Что я упускаю? У меня 2-ядерный процессор (максимальное использование в часы пик ~10%) и 2 ГБ ОЗУ (максимальное использование 60%).

короткое информация о веб-приложении: обычно каждый пользователь делает не менее 2 запросов за сеанс: статический ответ JSON и 1 запрос базы данных. В пиковое время у меня есть 15-20k активных пользователей, но я не знаю, сколько запросов в секунду я получаю. Однако медленные ответы начинаются с 5K активных пользователей.

я также увеличил Макс-активные соединения в свойствах приложения, без изменения производительности, моего текущего приложения.свойства:

spring.jpa.hibernate.ddl-auto=update

spring.datasource.driverClassName=com.mysql.jdbc.Driver

spring.datasource.url=jdbc:mysql://localhost:3306/database_name

spring.datasource.username=$username$

spring.datasource.password=$password$

spring.datasource.tomcat.max-active=200

spring.datasource.tomcat.max-wait=10000

spring.datasource.tomcat.max-idle=50

spring.datasource.tomcat.min-idle=10

spring.datasource.tomcat.initial-size=10

обновление

Я изменил значение по умолчанию JDBC пул подключений к Hikari со следующими конфигурациями и включенным jta, однако, не чувствовал никакой разницы в пиковые времена:

spring.jta.enabled=true

spring.datasource.hikari.maximum-pool-size=125

spring.datasource.hikari.minimum-idle=5

я добавляю запрос базы данных ниже. Результаты запроса позже добавляются в другой объект и возвращаются как ResponseBody.

@Query("select new ObjectClass(s.id, s.a, s.b, s.c") from TableName s " +

"where s.x > :param order by id desc")

List<ObjectClass> getObjects(@Param("param") long param);

использование процессора не растет, ОЗУ почти наполовину бесплатно, если у меня слишком много запросов, не должен ли я перегружать сервер? Вместо этого, я просто получаю медленное время отклика. Поэтому Я думаю, у меня есть проблема с конфигурацией, которую я хочу решить.

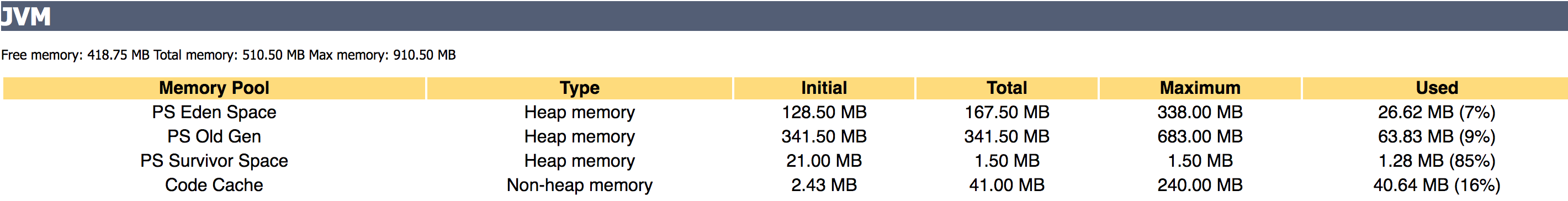

-Xms512M -Xmx1024M

приложение, которое висит на пиковое время:

Активные сеансы: 3243 количество сеансов: 475330 Макс Активные сеансы: 4685 отклоненные сеансы творения: 0 истекшие сеансы: 472105 самое длинное время сеанса: 7457 S среднее время сеанса: 9 s время обработки: 3177 МС Загружено JSPs: 0 JSPs reloaded: 0

трассировка стека:

"Attach Listener" #502 daemon prio=9 os_prio=0 tid=0x00007fde58007800 nid=0x3ff waiting on condition [0x0000000000000000]

java.lang.Thread.State: RUNNABLE

"Abandoned connection cleanup thread" #69 daemon prio=5 os_prio=0 tid=0x00007fde6c03e800 nid=0xa44 in Object.wait() [0x00007fde471ba000]

java.lang.Thread.State: TIMED_WAITING (on object monitor)

at java.lang.Object.wait(Native Method)

at java.lang.ref.ReferenceQueue.remove(ReferenceQueue.java:143)

- locked <0x00000000c259e618> (a java.lang.ref.ReferenceQueue$Lock)

at com.mysql.jdbc.AbandonedConnectionCleanupThread.run(AbandonedConnectionCleanupThread.java:64)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1149)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-exec-25" #68 daemon prio=5 os_prio=0 tid=0x00007fde40016000 nid=0x741 waiting on condition [0x00007fde35fe0000]

java.lang.Thread.State: TIMED_WAITING (parking)

at sun.misc.Unsafe.park(Native Method)

- parking to wait for <0x00000000c1cc6758> (a java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject)

at java.util.concurrent.locks.LockSupport.parkNanos(LockSupport.java:215)

at java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject.awaitNanos(AbstractQueuedSynchronizer.java:2078)

at java.util.concurrent.LinkedBlockingQueue.poll(LinkedBlockingQueue.java:467)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:85)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:31)

at java.util.concurrent.ThreadPoolExecutor.getTask(ThreadPoolExecutor.java:1073)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1134)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at org.apache.tomcat.util.threads.TaskThread$WrappingRunnable.run(TaskThread.java:61)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-exec-11" #54 daemon prio=5 os_prio=0 tid=0x00007fde38041800 nid=0x733 waiting on condition [0x00007fde36fee000]

java.lang.Thread.State: TIMED_WAITING (parking)

at sun.misc.Unsafe.park(Native Method)

- parking to wait for <0x00000000c1cc6758> (a java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject)

at java.util.concurrent.locks.LockSupport.parkNanos(LockSupport.java:215)

at java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject.awaitNanos(AbstractQueuedSynchronizer.java:2078)

at java.util.concurrent.LinkedBlockingQueue.poll(LinkedBlockingQueue.java:467)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:85)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:31)

at java.util.concurrent.ThreadPoolExecutor.getTask(ThreadPoolExecutor.java:1073)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1134)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at org.apache.tomcat.util.threads.TaskThread$WrappingRunnable.run(TaskThread.java:61)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-AsyncTimeout" #52 daemon prio=5 os_prio=0 tid=0x00007fde884e8800 nid=0x732 waiting on condition [0x00007fde370ef000]

java.lang.Thread.State: TIMED_WAITING (sleeping)

at java.lang.Thread.sleep(Native Method)

at org.apache.coyote.AbstractProtocol$AsyncTimeout.run(AbstractProtocol.java:1211)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-Acceptor-0" #51 daemon prio=5 os_prio=0 tid=0x00007fde884e6800 nid=0x731 runnable [0x00007fde371f0000]

java.lang.Thread.State: RUNNABLE

at sun.nio.ch.ServerSocketChannelImpl.accept0(Native Method)

at sun.nio.ch.ServerSocketChannelImpl.accept(ServerSocketChannelImpl.java:422)

at sun.nio.ch.ServerSocketChannelImpl.accept(ServerSocketChannelImpl.java:250)

- locked <0x00000000c019d7e8> (a java.lang.Object)

at org.apache.tomcat.util.net.NioEndpoint$Acceptor.run(NioEndpoint.java:455)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-ClientPoller-1" #50 daemon prio=5 os_prio=0 tid=0x00007fde884e4800 nid=0x730 runnable [0x00007fde372f1000]

java.lang.Thread.State: RUNNABLE

at sun.nio.ch.EPollArrayWrapper.epollWait(Native Method)

at sun.nio.ch.EPollArrayWrapper.poll(EPollArrayWrapper.java:269)

at sun.nio.ch.EPollSelectorImpl.doSelect(EPollSelectorImpl.java:93)

at sun.nio.ch.SelectorImpl.lockAndDoSelect(SelectorImpl.java:86)

- locked <0x00000000c1da2fa0> (a sun.nio.ch.Util)

- locked <0x00000000c1da2f90> (a java.util.Collections$UnmodifiableSet)

- locked <0x00000000c1d5b1e0> (a sun.nio.ch.EPollSelectorImpl)

at sun.nio.ch.SelectorImpl.select(SelectorImpl.java:97)

at org.apache.tomcat.util.net.NioEndpoint$Poller.run(NioEndpoint.java:787)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-ClientPoller-0" #49 daemon prio=5 os_prio=0 tid=0x00007fde884d6000 nid=0x72f runnable [0x00007fde373f2000]

java.lang.Thread.State: RUNNABLE

at sun.nio.ch.EPollArrayWrapper.epollWait(Native Method)

at sun.nio.ch.EPollArrayWrapper.poll(EPollArrayWrapper.java:269)

at sun.nio.ch.EPollSelectorImpl.doSelect(EPollSelectorImpl.java:93)

at sun.nio.ch.SelectorImpl.lockAndDoSelect(SelectorImpl.java:86)

- locked <0x00000000c1d510d8> (a sun.nio.ch.Util)

- locked <0x00000000c1d510c8> (a java.util.Collections$UnmodifiableSet)

- locked <0x00000000c1ce78c0> (a sun.nio.ch.EPollSelectorImpl)

at sun.nio.ch.SelectorImpl.select(SelectorImpl.java:97)

at org.apache.tomcat.util.net.NioEndpoint$Poller.run(NioEndpoint.java:787)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-exec-10" #48 daemon prio=5 os_prio=0 tid=0x00007fde884c7000 nid=0x72e waiting on condition [0x00007fde374f3000]

java.lang.Thread.State: TIMED_WAITING (parking)

at sun.misc.Unsafe.park(Native Method)

- parking to wait for <0x00000000c1cc6758> (a java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject)

at java.util.concurrent.locks.LockSupport.parkNanos(LockSupport.java:215)

at java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject.awaitNanos(AbstractQueuedSynchronizer.java:2078)

at java.util.concurrent.LinkedBlockingQueue.poll(LinkedBlockingQueue.java:467)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:85)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:31)

at java.util.concurrent.ThreadPoolExecutor.getTask(ThreadPoolExecutor.java:1073)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1134)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at org.apache.tomcat.util.threads.TaskThread$WrappingRunnable.run(TaskThread.java:61)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-exec-2" #40 daemon prio=5 os_prio=0 tid=0x00007fde884b7000 nid=0x726 waiting on condition [0x00007fde37cfb000]

java.lang.Thread.State: TIMED_WAITING (parking)

at sun.misc.Unsafe.park(Native Method)

- parking to wait for <0x00000000c1cc6758> (a java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject)

at java.util.concurrent.locks.LockSupport.parkNanos(LockSupport.java:215)

at java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject.awaitNanos(AbstractQueuedSynchronizer.java:2078)

at java.util.concurrent.LinkedBlockingQueue.poll(LinkedBlockingQueue.java:467)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:85)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:31)

at java.util.concurrent.ThreadPoolExecutor.getTask(ThreadPoolExecutor.java:1073)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1134)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at org.apache.tomcat.util.threads.TaskThread$WrappingRunnable.run(TaskThread.java:61)

at java.lang.Thread.run(Thread.java:748)

"ajp-nio-8009-exec-1" #39 daemon prio=5 os_prio=0 tid=0x00007fde884b5000 nid=0x725 waiting on condition [0x00007fde37dfc000]

java.lang.Thread.State: TIMED_WAITING (parking)

at sun.misc.Unsafe.park(Native Method)

- parking to wait for <0x00000000c1cc6758> (a java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject)

at java.util.concurrent.locks.LockSupport.parkNanos(LockSupport.java:215)

at java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject.awaitNanos(AbstractQueuedSynchronizer.java:2078)

at java.util.concurrent.LinkedBlockingQueue.poll(LinkedBlockingQueue.java:467)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:85)

at org.apache.tomcat.util.threads.TaskQueue.poll(TaskQueue.java:31)

at java.util.concurrent.ThreadPoolExecutor.getTask(ThreadPoolExecutor.java:1073)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1134)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at org.apache.tomcat.util.threads.TaskThread$WrappingRunnable.run(TaskThread.java:61)

at java.lang.Thread.run(Thread.java:748)

"http-nio-127.0.0.1-8080-AsyncTimeout" #38 daemon prio=5 os_prio=0 tid=0x00007fde884b3000 nid=0x724 waiting on condition [0x00007fde37efd000]

java.lang.Thread.State: TIMED_WAITING (sleeping)

at java.lang.Thread.sleep(Native Method)

at org.apache.coyote.AbstractProtocol$AsyncTimeout.run(AbstractProtocol.java:1211)

at java.lang.Thread.run(Thread.java:748)

"http-nio-127.0.0.1-8080-Acceptor-0" #37 daemon prio=5 os_prio=0 tid=0x00007fde884b1800 nid=0x723 runnable [0x00007fde37ffe000]

java.lang.Thread.State: RUNNABLE

at sun.nio.ch.ServerSocketChannelImpl.accept0(Native Method)

at sun.nio.ch.ServerSocketChannelImpl.accept(ServerSocketChannelImpl.java:422)

at sun.nio.ch.ServerSocketChannelImpl.accept(ServerSocketChannelImpl.java:250)

- locked <0x00000000c01a03b8> (a java.lang.Object)

at org.apache.tomcat.util.net.NioEndpoint$Acceptor.run(NioEndpoint.java:455)

at java.lang.Thread.run(Thread.java:748)

"http-nio-127.0.0.1-8080-exec-1" #25 daemon prio=5 os_prio=0 tid=0x00007fde88324000 nid=0x717 waiting on condition [0x00007fde46db8000]

java.lang.Thread.State: WAITING (parking)

at sun.misc.Unsafe.park(Native Method)

- parking to wait for <0x00000000c1d9c4e0> (a java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject)

at java.util.concurrent.locks.LockSupport.park(LockSupport.java:175)

at java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject.await(AbstractQueuedSynchronizer.java:2039)

at java.util.concurrent.LinkedBlockingQueue.take(LinkedBlockingQueue.java:442)

at org.apache.tomcat.util.threads.TaskQueue.take(TaskQueue.java:103)

at org.apache.tomcat.util.threads.TaskQueue.take(TaskQueue.java:31)

at java.util.concurrent.ThreadPoolExecutor.getTask(ThreadPoolExecutor.java:1074)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1134)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at org.apache.tomcat.util.threads.TaskThread$WrappingRunnable.run(TaskThread.java:61)

at java.lang.Thread.run(Thread.java:748)

"ContainerBackgroundProcessor[StandardEngine[Catalina]]" #24 daemon prio=5 os_prio=0 tid=0x00007fde88323000 nid=0x716 waiting on condition [0x00007fde476bb000]

java.lang.Thread.State: TIMED_WAITING (sleeping)

at java.lang.Thread.sleep(Native Method)

at org.apache.catalina.core.ContainerBase$ContainerBackgroundProcessor.run(ContainerBase.java:1355)

at java.lang.Thread.run(Thread.java:748)

"Abandoned connection cleanup thread" #22 daemon prio=5 os_prio=0 tid=0x00007fde4ca72800 nid=0x6f5 in Object.wait() [0x00007fde45c22000]

java.lang.Thread.State: TIMED_WAITING (on object monitor)

at java.lang.Object.wait(Native Method)

at java.lang.ref.ReferenceQueue.remove(ReferenceQueue.java:143)

- locked <0x00000000c102c4b0> (a java.lang.ref.ReferenceQueue$Lock)

at com.mysql.jdbc.AbandonedConnectionCleanupThread.run(AbandonedConnectionCleanupThread.java:64)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1149)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at java.lang.Thread.run(Thread.java:748)

"Tomcat JDBC Pool Cleaner[1595428806:1507838479700]" #21 daemon prio=5 os_prio=0 tid=0x00007fde4ca5b800 nid=0x6f4 in Object.wait() [0x00007fde470b9000]

java.lang.Thread.State: TIMED_WAITING (on object monitor)

at java.lang.Object.wait(Native Method)

at java.util.TimerThread.mainLoop(Timer.java:552)

- locked <0x00000000c0f6fe80> (a java.util.TaskQueue)

at java.util.TimerThread.run(Timer.java:505)

"NioBlockingSelector.BlockPoller-2" #13 daemon prio=5 os_prio=0 tid=0x00007fde8847e000 nid=0x66f runnable [0x00007fde478bd000]

java.lang.Thread.State: RUNNABLE

at sun.nio.ch.EPollArrayWrapper.epollWait(Native Method)

at sun.nio.ch.EPollArrayWrapper.poll(EPollArrayWrapper.java:269)

at sun.nio.ch.EPollSelectorImpl.doSelect(EPollSelectorImpl.java:93)

at sun.nio.ch.SelectorImpl.lockAndDoSelect(SelectorImpl.java:86)

- locked <0x00000000c019bd40> (a sun.nio.ch.Util)

- locked <0x00000000c019bd30> (a java.util.Collections$UnmodifiableSet)

- locked <0x00000000c019bbf8> (a sun.nio.ch.EPollSelectorImpl)

at sun.nio.ch.SelectorImpl.select(SelectorImpl.java:97)

at org.apache.tomcat.util.net.NioBlockingSelector$BlockPoller.run(NioBlockingSelector.java:339)

"NioBlockingSelector.BlockPoller-1" #12 daemon prio=5 os_prio=0 tid=0x00007fde8846f800 nid=0x66e runnable [0x00007fde479be000]

java.lang.Thread.State: RUNNABLE

at sun.nio.ch.EPollArrayWrapper.epollWait(Native Method)

at sun.nio.ch.EPollArrayWrapper.poll(EPollArrayWrapper.java:269)

at sun.nio.ch.EPollSelectorImpl.doSelect(EPollSelectorImpl.java:93)

at sun.nio.ch.SelectorImpl.lockAndDoSelect(SelectorImpl.java:86)

- locked <0x00000000c019ec10> (a sun.nio.ch.Util)

- locked <0x00000000c019ec00> (a java.util.Collections$UnmodifiableSet)

- locked <0x00000000c019ead8> (a sun.nio.ch.EPollSelectorImpl)

at sun.nio.ch.SelectorImpl.select(SelectorImpl.java:97)

at org.apache.tomcat.util.net.NioBlockingSelector$BlockPoller.run(NioBlockingSelector.java:339)

"GC Daemon" #11 daemon prio=2 os_prio=0 tid=0x00007fde883f9000 nid=0x66b in Object.wait() [0x00007fde741c6000]

java.lang.Thread.State: TIMED_WAITING (on object monitor)

at java.lang.Object.wait(Native Method)

- waiting on <0x00000000c02f16d8> (a sun.misc.GC$LatencyLock)

at sun.misc.GC$Daemon.run(GC.java:117)

- locked <0x00000000c02f16d8> (a sun.misc.GC$LatencyLock)

"AsyncFileHandlerWriter-1510467688" #10 daemon prio=5 os_prio=0 tid=0x00007fde88168800 nid=0x63e waiting on condition [0x00007fde7475c000]

java.lang.Thread.State: TIMED_WAITING (parking)

at sun.misc.Unsafe.park(Native Method)

- parking to wait for <0x00000000c02f16e8> (a java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject)

at java.util.concurrent.locks.LockSupport.parkNanos(LockSupport.java:215)

at java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject.awaitNanos(AbstractQueuedSynchronizer.java:2078)

at java.util.concurrent.LinkedBlockingDeque.pollFirst(LinkedBlockingDeque.java:522)

at java.util.concurrent.LinkedBlockingDeque.poll(LinkedBlockingDeque.java:684)

at org.apache.juli.AsyncFileHandler$LoggerThread.run(AsyncFileHandler.java:160)

"Service Thread" #7 daemon prio=9 os_prio=0 tid=0x00007fde880af000 nid=0x62e runnable [0x0000000000000000]

java.lang.Thread.State: RUNNABLE

"C1 CompilerThread1" #6 daemon prio=9 os_prio=0 tid=0x00007fde880ac000 nid=0x62d waiting on condition [0x0000000000000000]

java.lang.Thread.State: RUNNABLE

"C2 CompilerThread0" #5 daemon prio=9 os_prio=0 tid=0x00007fde880a9000 nid=0x62c waiting on condition [0x0000000000000000]

java.lang.Thread.State: RUNNABLE

"Signal Dispatcher" #4 daemon prio=9 os_prio=0 tid=0x00007fde880a7000 nid=0x62b runnable [0x0000000000000000]

java.lang.Thread.State: RUNNABLE

"Finalizer" #3 daemon prio=8 os_prio=0 tid=0x00007fde88080000 nid=0x625 in Object.wait() [0x00007fde74f33000]

java.lang.Thread.State: WAITING (on object monitor)

at java.lang.Object.wait(Native Method)

at java.lang.ref.ReferenceQueue.remove(ReferenceQueue.java:143)

- locked <0x00000000c02f7408> (a java.lang.ref.ReferenceQueue$Lock)

at java.lang.ref.ReferenceQueue.remove(ReferenceQueue.java:164)

at java.lang.ref.Finalizer$FinalizerThread.run(Finalizer.java:209)

"Reference Handler" #2 daemon prio=10 os_prio=0 tid=0x00007fde8807b800 nid=0x622 in Object.wait() [0x00007fde75034000]

java.lang.Thread.State: WAITING (on object monitor)

at java.lang.Object.wait(Native Method)

at java.lang.Object.wait(Object.java:502)

at java.lang.ref.Reference.tryHandlePending(Reference.java:191)

- locked <0x00000000c02f7490> (a java.lang.ref.Reference$Lock)

at java.lang.ref.Reference$ReferenceHandler.run(Reference.java:153)

"main" #1 prio=5 os_prio=0 tid=0x00007fde8800a800 nid=0x589 runnable [0x00007fde8f6af000]

java.lang.Thread.State: RUNNABLE

at java.net.PlainSocketImpl.socketAccept(Native Method)

at java.net.AbstractPlainSocketImpl.accept(AbstractPlainSocketImpl.java:409)

at java.net.ServerSocket.implAccept(ServerSocket.java:545)

at java.net.ServerSocket.accept(ServerSocket.java:513)

at org.apache.catalina.core.StandardServer.await(StandardServer.java:466)

at org.apache.catalina.startup.Catalina.await(Catalina.java:744)

at org.apache.catalina.startup.Catalina.start(Catalina.java:690)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:62)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

at java.lang.reflect.Method.invoke(Method.java:498)

at org.apache.catalina.startup.Bootstrap.start(Bootstrap.java:355)

at org.apache.catalina.startup.Bootstrap.main(Bootstrap.java:495)

"VM Thread" os_prio=0 tid=0x00007fde88073800 nid=0x5fd runnable

"GC task thread#0 (ParallelGC)" os_prio=0 tid=0x00007fde8801f800 nid=0x597 runnable

"GC task thread#1 (ParallelGC)" os_prio=0 tid=0x00007fde88021000 nid=0x598 runnable

"VM Periodic Task Thread" os_prio=0 tid=0x00007fde880bd800 nid=0x62f waiting on condition

JNI global references: 317

обновление: Хотя я не решил свою проблему, ответ @Per Huss подтолкнул меня в правильном направлении при анализе каждого потока отдельно и найти проблему. Я должен присудить свою награду сейчас, поэтому я вручу ее ему. Тем не менее, я благодарю всех, кто прокомментировал здесь, так как все комментарии помогли мне узнать что-то новое.

обновление 2:

Это выглядит как и проблема в apache. В пиковые времена даже статические страницы имеют медленное время отклика, даже из других приложений. В том числе менеджер tomcat. Итак, я изменился prefork to mpm_worker и в настоящее время тестирование различных конфигураций. Я обновлю этот поток с результатами, в ближайшее время.

6 ответов

Я боюсь, что в настоящее время вопрос не имеет достаточной информации ни для чего, кроме догадок. Низкое использование ЦП указывает на то, что ваш процесс java ждет чего-то, что может быть что угодно от получения соединения с базой данных, ожидания результата запроса или чего-либо еще. Я бы начал с того, что посмотрел на что вызывает ожидание, прежде чем пытаться его исправить. Один из способов сделать это-запустить

jstack <pid>

(где <pid> будет твой процесс ' pid) во время пика. Он отобразит трассировку стека для каждого потока. Вы можете определить проблему из этого, или вы можете вставить ее в вопрос, и, возможно, сообщество может помочь вам. Удачи с настройкой!

вы можете разрешить столько потоков, сколько хотите, но если количество запросов увеличивается, то время ответа СУБД будет ухудшаться, что, вероятно, является вашей основной причиной.

вам нужно определить, где он узкое место. Создайте фиктивную страницу и выдайте ей запросы как маньяк с нескольких компьютеров. Если фиктивная страница отвечает вовремя, то ваша проблема слабо связана, если вообще с номером подключения и многое другое с вашей базой данных. Весьма вероятно, что это случай.

взгляните на свою базу данных, убедитесь, что ваша схема находится в нормальной форме. Кроме того, при частом поиске по некоторым столбцам убедитесь, что созданы правильные индексы. Взгляните на свои запросы и понаблюдайте, не являются ли они излишне медленными. Если да, оптимизируйте их. Кэшируйте некоторые данные, которые не меняются слишком часто, и используйте их повторно.

при использовании spring по умолчанию используется Tomcat. Как вы можете использовать Netty или Undertow или Jetty для лучшей производительности. Пожалуйста, также помните, что, несмотря на наличие 2 core CPU, у вас на самом деле нет 500 потоков.

Как когда-либо выше ответ на самом деле имитировать, как ваше приложение реагирует на трафик, вероятно, лучший способ пойти. Если вы используете базу данных отношений, помните, что запись может быть даже в десять раз медленнее, чем чтение (вы можете увидеть интересную статистику по этому в Cassandra документация.) Если вы используете hibernate, вы можете также искать проблему n+1. Лучший способ сделать это: написать интеграционный тест, зарегистрировать sql, отправленный в базу данных. Если ваш тест отправляет 51 вместо одного запроса, у вас есть это.

Если существует так много соединений, не следует ли tomcat создавать больше потоков (до 500) реагировать быстрее?

=> согласно документам Tomcat8, если получено больше одновременных запросов, чем может быть обработано текущими потоками обработки запросов, дополнительные потоки будут созданы до настроенного максимума (значение атрибута maxThreads). Если еще больше одновременных запросов, они складываются внутри сокета сервера созданный соединителем, до настроенного максимума (значение атрибута acceptCount).

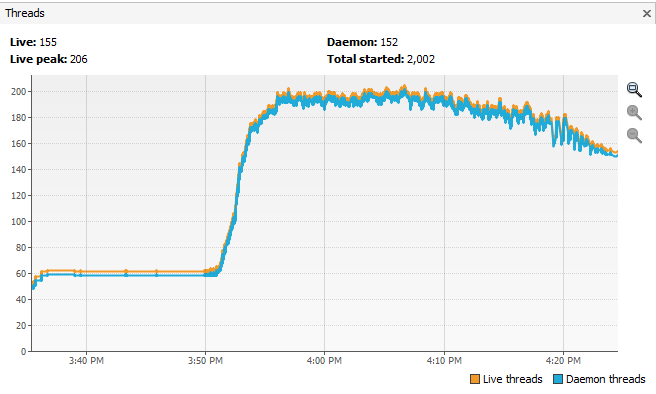

таким образом, ваш tomcat должен создавать потоки по мере необходимости. Кроме того, Tomcat 8 по умолчанию работает в режиме NIO, что означает, что один поток может обслуживать несколько запросов. Вы можете подтвердить это поведение, запустив инструмент мониторинга, такой как" jvisualvm", во время нагрузочного теста.

видео потоков: это показывает текущее количество живых / активных потоков включая как демонические, так и не-демонические потоки(в настоящее время запущенные).

видео потоков: это показывает текущее количество живых / активных потоков включая как демонические, так и не-демонические потоки(в настоящее время запущенные).

Live Peak: это дает пиковое количество живых потоков с момента запуска виртуальной машины Java или сброса пика.

Daemon Потоки: это дает текущее количество потоков Live daemon.

Общая Потоков: это дает общее количество потоков, созданных и также запущенных с момента запуска виртуальной машины Java.

Итак, что я делаю не так? Что я упускаю? У меня есть 2 core CPU (Макс использование в часы пик ~10%) и 2 ГБ ОЗУ (максимальное использование 60%).использование процессора не растет, RAM почти наполовину свободен, если у меня слишком много запросы, разве я не должен был перегружать сервер? Вместо этого я просто получаю медленное время отклика.

=>IMO, потоки блокируются при извлечении данных из БД. Это может быть связано с низкой производительностью запроса во время загрузки. Я бы предложил включить "зимовать.show_sql " захват SQL. Проверьте план выполнения SQL, убедитесь, что применяются индексы. Вы также можете проверить производительность запроса во время загрузки, выполнив его на клиенте SQL.

Я, наконец, решил свою проблему. На самом деле, это был apache, который не позволял достаточно соединений. Прежде всего, я изменился prefork to mpm worker. Позже я увеличил число MaxRequestWorkers.

<IfModule mpm_worker_module>

StartServers 2

MinSpareThreads 50

MaxSpareThreads 125

ThreadLimit 64

ThreadsPerChild 25

ServerLimit 5000

MaxRequestWorkers 5000

MaxConnectionsPerChild 4500

ранее я получал медленное время отклика уже с 3000 активными пользователями. С новой конфигурацией даже 17000 активных пользователей не увеличили время отклика, и он работал как в обычное время. Как и ожидалось, использование процессора и ОЗУ увеличилось в пиковое время, а затем пошло в норму.

в таких ошибках, прежде всего, мы должны определить, где проблема . Здесь дается план действий для отладки этих типов проблем:

например, в вашем случае

запросы поступают от пользователя к tomcat, затем он передаст его вашему приложению .

прежде всего, проверьте, где проблема, т. е. могут быть проблемы в следующих местах:

- любой api приложения или все api начали принимать время, но потоки tomcat свободны

- ваши потоки tomcat не бесплатны, и обработка каждого из них занимает время, поэтому происходит задержка

- вы база данных начинает принимать время

- как вы запрашиваете базу данных, может быть случай, что больше данных загружается в ваше приложение и некоторые проблемы Java gc начал происходит

и в первом случае, пожалуйста, проверьте журналы приложений, и если журналы не там, пожалуйста, поместите журналы и проверьте, если любое из ваших приложений занимает время (журналы никогда не лгут )

во втором случае, Проверьте свои журналы tomcat, что такое условие там .

в третьем случае, пожалуйста, проверьте журналы базы данных, что запросы занимают больше времени или нет .

в четвертом случае, вы можете контролировать свой мониторинг работоспособности java , на рынке есть много инструментов, таких как jfr, jcisualvm и т. д..

кроме того, ваш вопрос недостаточно объяснений, пожалуйста, ответьте на следующее

- что структура образца вашего применения?

- что вы делаете, чтобы вернуть приложение не в нормальное состояние, например, перезапуск решает вашу проблему или нет? Я спрашиваю об этом, потому что если вам нужно перезапустить его, то может быть тупик, поэтому вам может потребоваться взять jstack и проанализировать его

- сколько XMX дается приложению?

- ваш сервер баз данных и приложение сервер на той же машине? Потому что может быть какая-то проблема ввода-вывода в пиковое время на какой-то машине, поэтому нам нужно проверить оба

пожалуйста определите сперва где проблема, тогда мы можем продолжать дальше, как мы можем определить и разрешить вопрос .

спасибо